Imagen del editor

Las aplicaciones de IA poseen capacidades computacionales incomparables que pueden impulsar el progreso a un ritmo sin precedentes. Sin embargo, estas herramientas dependen en gran medida de centros de datos que consumen mucha energía para sus operaciones, lo que resulta en una preocupante falta de sensibilidad energética que contribuye significativamente a su huella de carbono. Sorprendentemente, estas aplicaciones de IA ya representan una parte sustancial 2,5 a 3,7 por ciento de las emisiones globales de gases de efecto invernadero, superando las emisiones de la industria de la aviación.

Y, lamentablemente, esta huella de carbono está aumentando a un ritmo rápido.

Actualmente, la necesidad apremiante es medir la huella de carbono de las aplicaciones de aprendizaje automático, como lo enfatiza Peter Drucker: “No se puede gestionar lo que no se puede medir”. Actualmente, existe una falta significativa de claridad a la hora de cuantificar el impacto ambiental de la IA, y se nos escapan cifras precisas.

Además de medir la huella de carbono, los líderes de la industria de la IA deben centrarse activamente en optimizarla. Este enfoque dual es vital para abordar las preocupaciones ambientales que rodean las aplicaciones de IA y garantizar un camino a seguir más sostenible.

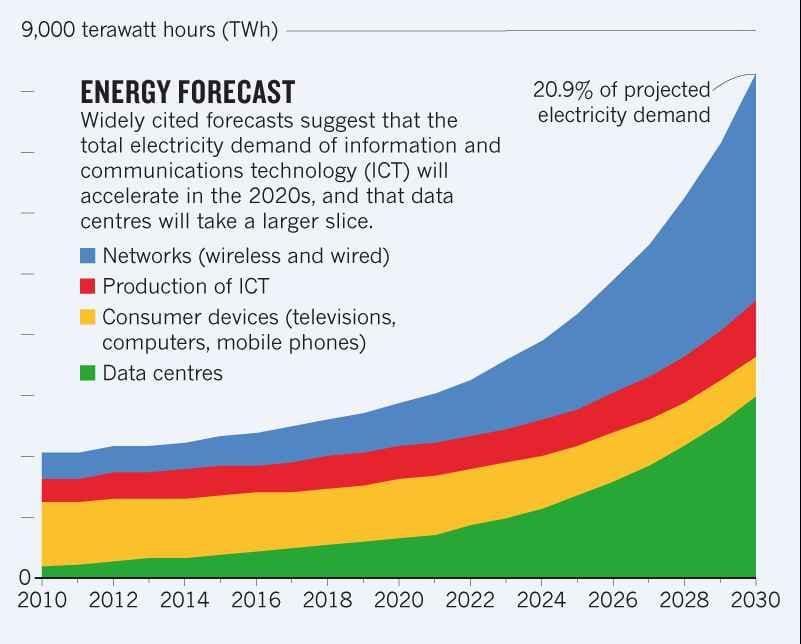

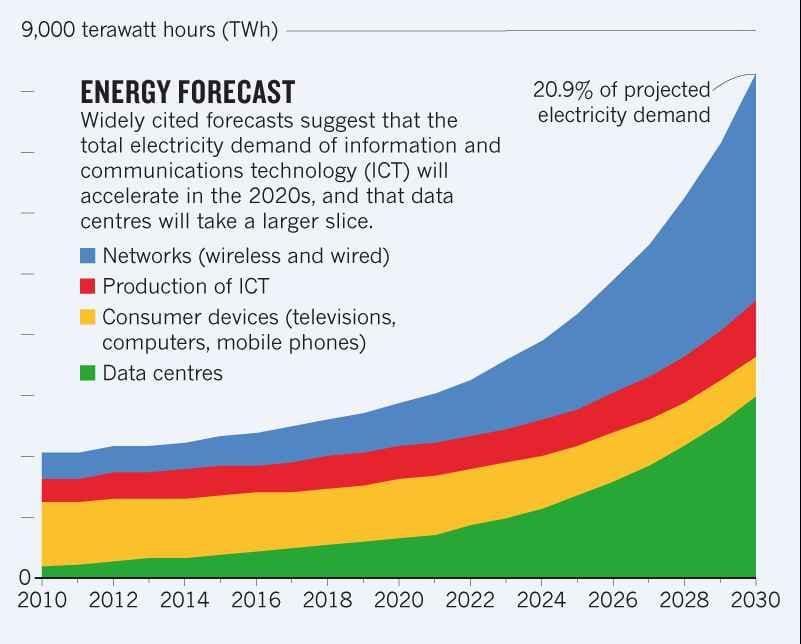

El mayor uso del aprendizaje automático requiere más centros de datos, muchos de los cuales consumen mucha energía y, por lo tanto, tienen una huella de carbono significativa. El uso global de electricidad por parte de los centros de datos ascendió a 0,9 a 1,3 por ciento en 2021.

A estudio 2021 Se estima que este uso puede aumentar al 1,86 por ciento para 2030. Este cifra representa la tendencia creciente de la demanda de energía debido a los centros de datos

© Tendencia del consumo de energía y porcentaje de uso de los centros de datos

En particular, cuanto mayor sea el consumo de energía, mayor será la huella de carbono. Los centros de datos se calientan durante el procesamiento y pueden fallar e incluso dejar de funcionar debido al sobrecalentamiento. Por tanto, necesitan refrigeración, lo que requiere energía adicional. Alrededor 40 por ciento de la electricidad consumida por los centros de datos se destina al aire acondicionado.

Dada la creciente huella del uso de la IA, es necesario tener en cuenta la intensidad de carbono de estas herramientas. Actualmente, la investigación sobre este tema se limita al análisis de unos pocos modelos y no aborda adecuadamente la diversidad de dichos modelos.

A continuación se presenta una metodología evolucionada y algunas herramientas efectivas para calcular la intensidad de carbono de los sistemas de IA.

La intensidad del carbono del software (SCI) estándar es un enfoque eficaz para estimar la intensidad de carbono de los sistemas de IA. A diferencia de las metodologías convencionales que emplean un enfoque de contabilidad de carbono atribucional, utiliza un enfoque informático consecuente.

El enfoque consecuencial intenta calcular el cambio marginal en las emisiones que surge de una intervención o decisión, como la decisión de generar una unidad adicional. Mientras que la atribución se refiere a contabilizar datos de intensidad promedio o inventarios estáticos de emisiones.

A papel sobre “Medición de la intensidad de carbono de la IA en instancias de la nube” por Jesse Doge et al. ha empleado esta metodología para generar investigaciones más informadas. Dado que una cantidad significativa de capacitación en modelos de IA se lleva a cabo en instancias de computación en la nube, puede ser un marco válido para calcular la huella de carbono de los modelos de IA. El artículo perfecciona la fórmula del SCI para estimaciones tales como:

que se refina a partir de:

que deriva de

que deriva de

dónde:

MI: Energía consumida por un sistema de software, principalmente de unidades de procesamiento gráfico (GPU), que es hardware de aprendizaje automático especializado.

I: Emisiones marginales de carbono basadas en la ubicación por parte de la red que alimenta el centro de datos.

METRO: Carbono incorporado o incorporado, que es el carbono emitido durante el uso, creación y eliminación del hardware.

R: Unidad funcional, que en este caso es una tarea de formación en aprendizaje automático.

C= O+M, donde O es igual a E*I

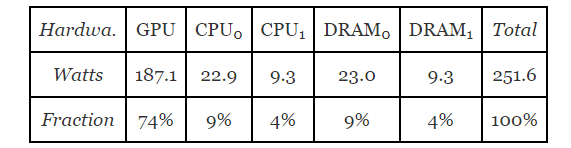

El documento utiliza la fórmula para estimar el uso de electricidad de una única instancia de nube. En los sistemas ML basados en deep learning el mayor consumo eléctrico se lo debe a la GPU, que se incluye en esta fórmula. Entrenaron un modelo basado en BERT utilizando una única GPU NVIDIA TITAN X (12 GB) en un servidor básico con dos CPU Intel Xeon E5-2630 v3 (2,4 GHz) y 256 GB de RAM (DIMM de 16 x 16 GB) para experimentar la aplicación de esta fórmula. La siguiente figura muestra los resultados de este experimento:

© Consumo de energía y división entre componentes de un servidor

La GPU reclama el 74 por ciento del consumo de energía. Aunque los autores del artículo todavía lo consideran una subestimación, la inclusión de GPU es el paso en la dirección correcta. No es el foco de las técnicas de estimación convencionales, lo que significa que en las estimaciones se pasa por alto un factor importante de la huella de carbono. Evidentemente, SCI ofrece un cálculo más sano y fiable de la intensidad de carbono.

La capacitación en modelos de IA a menudo se lleva a cabo en instancias informáticas en la nube, ya que la nube la hace flexible, accesible y rentable. La computación en la nube proporciona la infraestructura y los recursos para implementar y entrenar modelos de IA a escala. Es por eso que la formación de modelos en computación en la nube está aumentando gradualmente.

Es importante medir la intensidad de carbono en tiempo real de las instancias de computación en la nube para identificar áreas adecuadas para los esfuerzos de mitigación. La contabilidad de las emisiones marginales por unidad de energía basadas en el tiempo y específicas de la ubicación puede ayudar a calcular las emisiones operativas de carbono, como lo hace un papel 2022.

Un fuente abierta herramienta, el software Cloud Carbon Footprint (CCF) también está disponible para calcular el impacto de las instancias de la nube.

Aquí hay 7 formas de optimizar la intensidad de carbono de los sistemas de IA.

1. Escriba código mejor y más eficiente

Los códigos optimizados pueden reducir el consumo de energía al 30 por ciento a través de un menor uso de memoria y procesador. Escribir un código eficiente en carbono implica optimizar algoritmos para una ejecución más rápida, reducir cálculos innecesarios y seleccionar hardware energéticamente eficiente para realizar tareas con menos energía.

Los desarrolladores pueden utilizar herramientas de creación de perfiles para identificar cuellos de botella en el rendimiento y áreas de optimización en su código. Este proceso puede conducir a un software más eficiente energéticamente. Además, considere implementar técnicas de programación que tengan en cuenta la energía, donde el código esté diseñado para adaptarse a los recursos disponibles y priorizar rutas de ejecución energéticamente eficientes.

2. Seleccione un modelo más eficiente

Elegir los algoritmos y las estructuras de datos adecuados es fundamental. Los desarrolladores deberían optar por algoritmos que minimicen la complejidad computacional y, en consecuencia, el consumo de energía. Si el modelo más complejo solo produce una mejora del 3 al 5 % pero requiere de 2 a 3 veces más tiempo para entrenar; luego elija el modelo más simple y rápido.

La destilación de modelos es otra técnica para condensar modelos grandes en versiones más pequeñas para hacerlos más eficientes y al mismo tiempo conservar el conocimiento esencial. Se puede lograr entrenando un modelo pequeño para imitar el grande o eliminando conexiones innecesarias de una red neuronal.

3. Ajustar los parámetros del modelo

Ajuste los hiperparámetros del modelo mediante optimización de doble objetivo que equilibre el rendimiento del modelo (p. ej., precisión) y el consumo de energía. Este enfoque de doble objetivo garantiza que no se sacrifique uno por el otro, lo que hace que sus modelos sean más eficientes.

Aprovechar técnicas como Ajuste fino eficiente en los parámetros (PEFT) cuyo objetivo es lograr un rendimiento similar al ajuste fino tradicional pero con un número reducido de parámetros entrenables. Este enfoque implica ajustar un pequeño subconjunto de parámetros del modelo mientras se mantiene congelada la mayoría de los modelos de lenguaje grande (LLM) previamente entrenados, lo que resulta en reducciones significativas en los recursos computacionales y el consumo de energía.

4. Comprima datos y utilice almacenamiento de bajo consumo de energía

Implementar técnicas de compresión de datos para reducir la cantidad de datos transmitidos. Los datos comprimidos requieren menos energía para transferirse y ocupan menos espacio en el disco. Durante la fase de servicio del modelo, el uso de un caché puede ayudar a reducir las llamadas realizadas a la capa de almacenamiento en línea, reduciendo así

Además, elegir la tecnología de almacenamiento adecuada puede generar ganancias significativas. Por ej. AWS Glacier es una solución de archivado de datos eficiente y puede ser un enfoque más sostenible que usar S3 si no es necesario acceder a los datos con frecuencia.

5. Formar modelos sobre energías más limpias

Si utiliza un servicio en la nube para el entrenamiento de modelos, puede elegir la región para realizar los cálculos. Elija una región que emplee fuentes de energía renovables para este propósito y podrá reducir las emisiones hasta en 30 veces. AWS entrada en el blog Describe el equilibrio entre la optimización para el negocio y los objetivos de sostenibilidad.

Otra opción es seleccionar el momento oportuno para ejecutar el modelo. A determinadas horas del día; la energía es más limpia y dichos datos se pueden adquirir a través de un servicio pago como Mapa de electricidadque ofrece acceso a datos en tiempo real y predicciones futuras sobre la intensidad de carbono de la electricidad en diferentes regiones.

6. Utilice centros de datos y hardware especializados para la capacitación de modelos.

Elegir centros de datos y hardware más eficientes puede marcar una gran diferencia en la intensidad de carbono. Los centros de datos y el hardware específicos de ML pueden ser 1.4-2 y 2-5 veces más eficientes energéticamente que los generales.

7. Utilice implementaciones sin servidor como AWS Lambda y Azure Functions

Las implementaciones tradicionales requieren que el servidor esté siempre encendido, lo que significa un consumo de energía 24 horas al día, 7 días a la semana. Las implementaciones sin servidor como AWS Lambda y Azure Functions funcionan bien con una mínima intensidad de carbono.

El sector de la IA está experimentando un crecimiento exponencial, impregnando todas las facetas de los negocios y la existencia diaria. Sin embargo, esta expansión tiene un costo: una creciente huella de carbono que amenaza con alejarnos aún más del objetivo de limitar el aumento de la temperatura global a solo 1°C.

Esta huella de carbono no es sólo una preocupación actual; sus repercusiones pueden extenderse a través de generaciones, afectando a aquellos que no tienen ninguna responsabilidad por su creación. Por lo tanto, se vuelve imperativo tomar medidas decisivas para mitigar las emisiones de carbono relacionadas con la IA y explorar vías sostenibles para aprovechar su potencial. Es fundamental garantizar que los beneficios de la IA no se produzcan a expensas del medio ambiente y el bienestar de las generaciones futuras.

Ankur Gupta es un líder en ingeniería con una década de experiencia en los ámbitos de sostenibilidad, transporte, telecomunicaciones e infraestructura; Actualmente ocupa el cargo de Gerente de Ingeniería en Uber. En este cargo, desempeña un papel fundamental a la hora de impulsar el avance de la plataforma de vehículos de Uber, liderando el avance hacia un futuro sin emisiones mediante la integración de vehículos eléctricos y conectados de última generación.

NEWSLETTER

NEWSLETTER