A medida que los asistentes virtuales se vuelven omnipresentes, los usuarios interactúan cada vez más con ellos para aprender sobre nuevos temas u obtener recomendaciones y esperan que brinden capacidades más allá de los diálogos estrechos de uno o dos turnos. La planificación dinámica, es decir, la capacidad de mirar hacia adelante y replanificar en función del flujo de la conversación, es un ingrediente esencial para entablar conversaciones atractivas con las interacciones más profundas y abiertas que esperan los usuarios.

Si bien los modelos de lenguaje extenso (LLM) ahora superan los enfoques de vanguardia en muchos puntos de referencia de procesamiento de lenguaje natural, generalmente están capacitados para generar la siguiente mejor respuesta, en lugar de planificar con anticipación, lo que se requiere para las interacciones de varios turnos. Sin embargo, en los últimos años, aprendizaje reforzado (RL) ha brindado resultados increíbles al abordar problemas específicos que implican una planificación dinámica, como ganar juegos y el plegamiento de proteínas.

Hoy compartimos nuestros avances recientes en planificación dinámica para conversaciones de persona a asistente, en el que permitimos que un asistente planifique una conversación de varios turnos hacia un objetivo y adapte ese plan en tiempo real mediante la adopción de un enfoque basado en RL. Aquí vemos cómo mejorar las interacciones largas aplicando RL para redactar respuestas basadas en información extraída de fuentes confiables, en lugar de depender del contenido generado por un modelo de lenguaje. Esperamos que las versiones futuras de este trabajo puedan combinar LLM y RL en diálogos de varios turnos. El despliegue de RL “en la naturaleza” en un sistema de diálogo a gran escala resultó ser un desafío formidable debido a la complejidad del modelado, los espacios de acción y estado tremendamente grandes y la sutileza significativa en el diseño de funciones de recompensa.

¿Qué es la planificación dinámica?

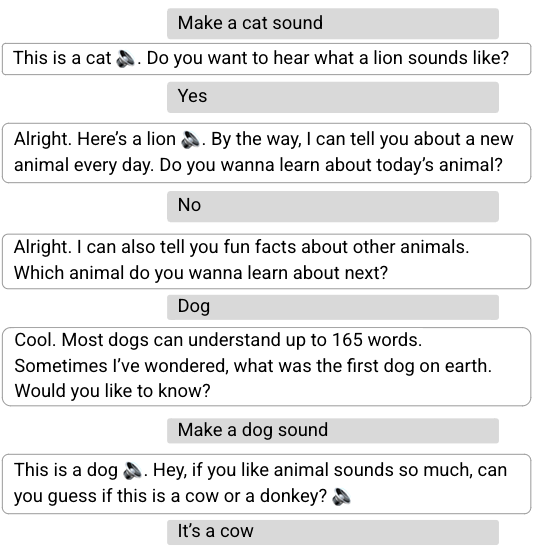

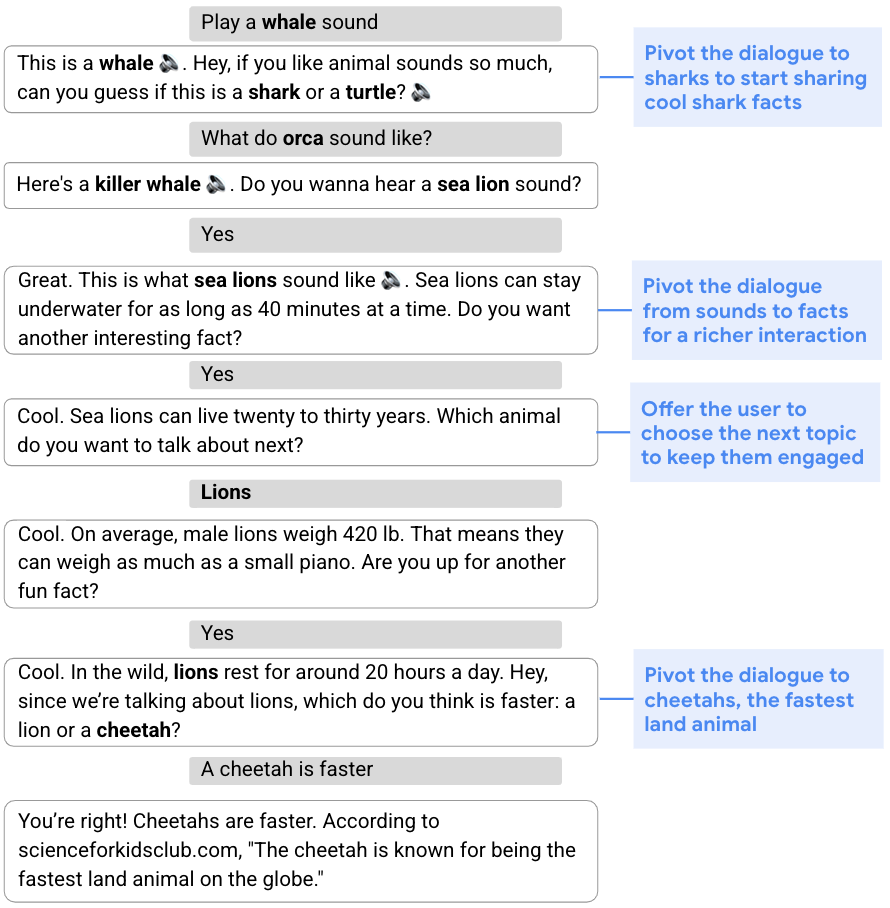

Muchos tipos de conversaciones, desde recopilar información hasta ofrecer recomendaciones, requieren un enfoque flexible y la capacidad de modificar el plan original de la conversación en función de su flujo. Esta capacidad de cambiar de marcha en medio de una conversación se conoce como planificación dinámicaOpuesto a planificación estática, que se refiere a un enfoque más fijo. En la conversación a continuación, por ejemplo, el objetivo es involucrar al usuario compartiendo datos interesantes sobre animales geniales. Para comenzar, el asistente dirige la conversación hacia los tiburones a través de un cuestionario de sonido. Dada la falta de interés del usuario en los tiburones, el asistente luego desarrolla un plan actualizado y gira la conversación hacia leones marinos, leones y luego guepardos.

|

| El asistente modifica dinámicamente su plan original para hablar sobre tiburones y comparte datos sobre otros animales. |

Composición dinámica

Para hacer frente al desafío de la exploración conversacional, separamos la generación de respuestas del asistente en dos partes: 1) generación de contenidoque extrae información relevante de fuentes acreditadas, y 2) composición flexible de dicho contenido en las respuestas del asistente. Nos referimos a este enfoque de dos partes como composición dinámica. A diferencia de los métodos LLM, este enfoque le brinda al asistente la capacidad de controlar completamente la fuente, la corrección y la calidad del contenido que puede ofrecer. Al mismo tiempo, puede lograr flexibilidad a través de un administrador de diálogo aprendido que selecciona y combina el contenido más apropiado.

En un artículo anterior, “Composición dinámica para la exploración del dominio conversacional”, describimos un enfoque novedoso que consiste en: (1) una colección de proveedores de contenido, que ofrecen candidatos de diferentes fuentes, como fragmentos de noticias, gráfico de conocimiento hechos y preguntas; (2) un administrador de diálogo; y (3) un módulo de fusión de oraciones. Cada respuesta del asistente es construida de manera incremental por el administrador de diálogo, que selecciona candidatos propuestos por los proveedores de contenido. La secuencia seleccionada de expresiones se fusiona luego en una respuesta cohesiva.

Planificación dinámica usando RL

En el núcleo del bucle de composición de respuesta del asistente se encuentra un administrador de diálogo capacitado para usar RL fuera de la política, es decir, un algoritmo que evalúa y mejora una política diferente a la utilizada por el agente (en nuestro caso, esta última se basa en un modelo supervisado). Aplicar RL a la gestión del diálogo presenta varios desafíos, incluido un gran espacio de estado (ya que el estado representa el estado de la conversación, que debe tener en cuenta todo el historial de la conversación) y un espacio de acción efectivamente ilimitado (que puede incluir todas las palabras u oraciones existentes en natural). idioma).

Abordamos estos desafíos utilizando una nueva construcción RL. Primero, aprovechamos poderosos modelos supervisados, específicamente, redes neuronales recurrentes (RNN) y transformadores, para proporcionar una representación de estado de diálogo sucinta y efectiva. Estos codificadores de estado se alimentan con el historial de diálogo, compuesto por una secuencia de turnos de usuario y asistente, y emiten una representación del estado del diálogo en forma de vector latente.

En segundo lugar, usamos el hecho de que los proveedores de contenido pueden generar un conjunto relativamente pequeño de declaraciones o acciones candidatas razonables en cada turno de conversación, y limitamos el espacio de acción a estos. Mientras que el espacio de acción generalmente se fija en la configuración de RL, porque todos los estados comparten el mismo espacio de acción, el nuestro es un espacio no estándar en el que las acciones candidatas pueden diferir con cada estado, ya que los proveedores de contenido generan diferentes acciones según el contexto del diálogo. Esto nos sitúa en el ámbito de los conjuntos de acciones estocásticas, un marco que formaliza los casos en los que el conjunto de acciones disponibles en cada estado se rige por un proceso estocástico exógeno, que abordamos utilizando Acción estocástica Q-Learninguna variante de la Q-aprendizaje acercarse. Q-learning es un popular algoritmo RL fuera de la política, que no requiere un modelo del entorno para evaluar y mejorar la política. Entrenamos nuestro modelo en un corpus de conversaciones clasificadas por computación de multitudes obtenidas utilizando un administrador de diálogo supervisado.

Evaluación del modelo de aprendizaje por refuerzo

Comparamos nuestro administrador de diálogo RL con un modelo de transformador supervisado lanzado en un experimento con el Asistente de Google, que conversaba con los usuarios sobre animales. Una conversación comienza cuando un usuario desencadena la experiencia al hacer una consulta relacionada con animales (p. ej., “¿Cómo suena un león?”). El experimento se realizó utilizando un Pruebas A/B protocolo, en el que se muestreó aleatoriamente un pequeño porcentaje de usuarios del Asistente para interactuar con nuestro asistente basado en RL, mientras que otros usuarios interactuaron con el asistente estándar.

Descubrimos que el administrador de diálogo de RL lleva a cabo conversaciones más largas y atractivas. Aumenta la duración de la conversación en un 30% al tiempo que mejora las métricas de participación del usuario. Vemos un aumento del 8% en las respuestas cooperativas a las preguntas del asistente, por ejemplo, “Háblame de los leones”, en respuesta a “¿Sobre qué animal quieres escuchar a continuación?” Aunque también hay un gran aumento en las respuestas nominalmente “no cooperativas” (p. ej., “No”, como respuesta a una pregunta que propone contenido adicional, como “¿Quiere saber más?”), se espera que esto El agente de RL toma más riesgos al hacer preguntas pivotantes. Si bien es posible que un usuario no esté interesado en la dirección de la conversación propuesta por el asistente (p. ej., girar hacia otro animal), el usuario a menudo continuará participando en un diálogo sobre animales.

Además, algunas consultas de los usuarios contienen comentarios explícitos positivos (p. ej., “Gracias, Google” o “Estoy feliz”) o negativos (p. ej., “Cállate” o “Para”). Si bien son un orden de magnitud menor que otras consultas, ofrecen una medida directa de la (des)satisfacción del usuario. El modelo RL aumenta la retroalimentación positiva explícita en un 32 % y reduce la retroalimentación negativa en un 18 %.

Características y estrategias de planificación dinámica aprendidas

Observamos varias características del plan RL (invisible) para mejorar la participación del usuario mientras se realizan conversaciones más largas. En primer lugar, el asistente basado en RL finaliza un 20 % más de turnos en las preguntas, lo que incita al usuario a elegir contenido adicional. También aprovecha mejor la diversidad de contenido, incluidos hechos, sonidos, cuestionarios, preguntas de sí/no, preguntas abiertas, etc. En promedio, el asistente de RL usa un 26 % más de proveedores de contenido distintos por conversación que el modelo supervisado.

Dos estrategias de planificación de RL observadas están relacionadas con la existencia de subdiálogos con características diferentes. Los subdiálogos sobre los sonidos de los animales tienen un contenido más pobre y exhiben entidades que giran en cada turno (es decir, después de reproducir el sonido de un animal determinado, podemos sugerir el sonido de un animal diferente o preguntar al usuario sobre otros sonidos de animales). Por el contrario, los subdiálogos que involucran hechos de animales generalmente contienen un contenido más rico y tienen una conversación más profunda. Observamos que RL favorece la experiencia más rica de este último, seleccionando un 31% más de contenido relacionado con hechos. Por último, al restringir el análisis a diálogos relacionados con hechos, el asistente de RL exhibe un 60 % más de giros de pivote de enfoque, es decir, giros conversacionales que cambian el enfoque del diálogo.

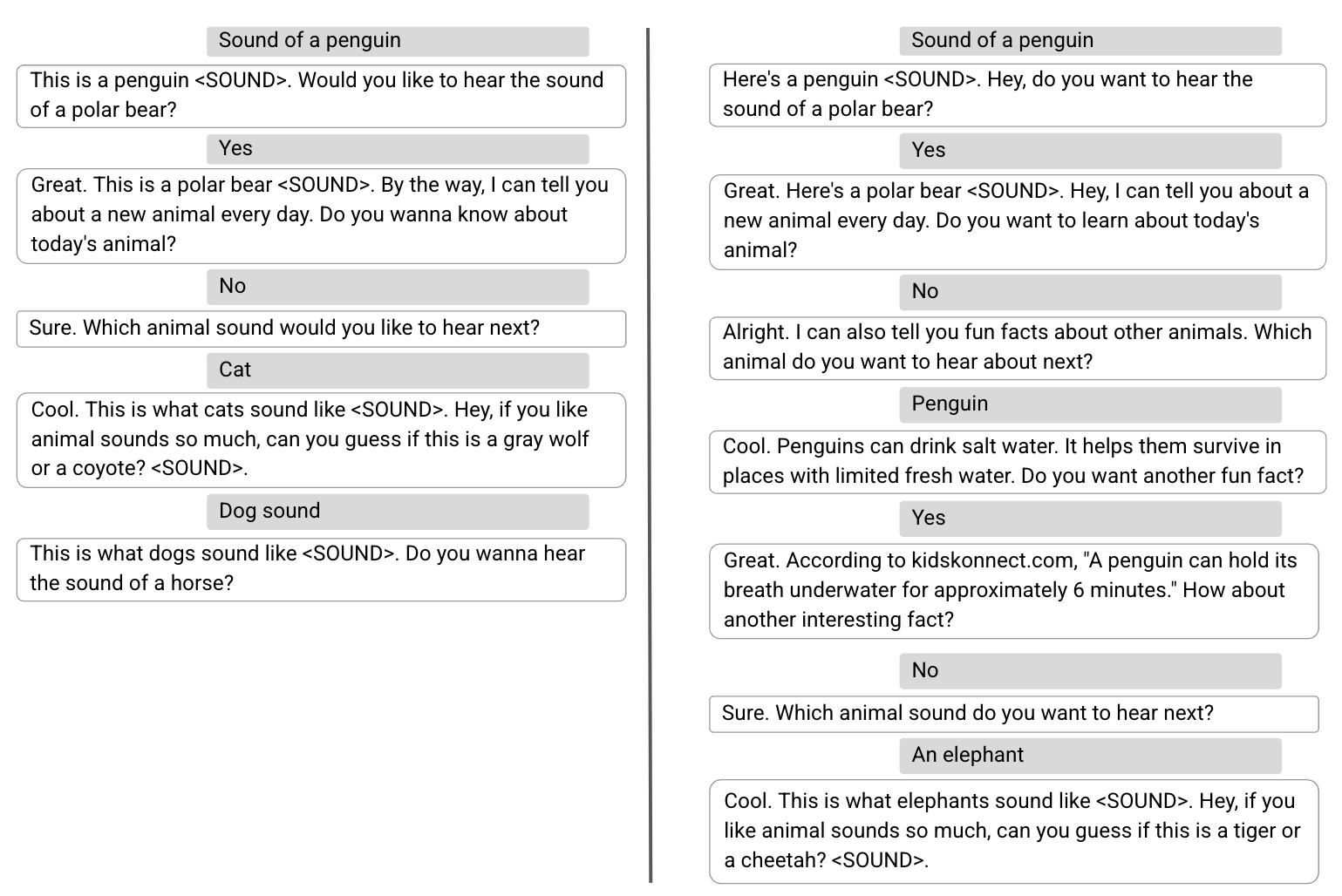

A continuación, mostramos dos conversaciones de ejemplo, una realizada por el modelo supervisado (izquierda) y la segunda por el modelo RL (derecha), en las que los primeros tres turnos de usuario son idénticos. Con un administrador de diálogo supervisado, después de que el usuario se negó a escuchar sobre el “animal de hoy”, el asistente vuelve a los sonidos de los animales para maximizar la satisfacción inmediata del usuario. Si bien la conversación conducida por el modelo RL comienza de manera idéntica, exhibe una estrategia de planificación diferente para optimizar la participación general del usuario, introduciendo contenido más diverso, como datos divertidos.

Futuras investigaciones y desafíos

En los últimos años, los LLM capacitados para la comprensión y generación de idiomas han demostrado resultados impresionantes en múltiples tareas, incluido el diálogo. Ahora estamos explorando el uso de un marco RL para empoderar a los LLM con la capacidad de planificación dinámica para que puedan planificar dinámicamente con anticipación y deleitar a los usuarios con una experiencia más atractiva.

Agradecimientos

El trabajo descrito es coautor de: Moonkyung Ryu, Yinlam Chow, Orgad Keller, Ido Greenberg, Avinatan Hassidim, Michael Fink, Yossi Matias, Idan Szpektor y Gal Elidan. Nos gustaría agradecer a: Roee Aharoni, Moran Ambar, John Anderson, Ido Cohn, Mohammad Ghavamzadeh, Lotem Golany, Ziv Hodak, Adva Levin, Fernando Pereira, Shimi Salant, Shachar Shimoni, Ronit Slyper, Ariel Stolovich, Hagai Taitelbaum, Noam Velan , Avital Zipori y el equipo de CrowdCompute dirigido por Ashwin Kakarla. Agradecemos a Sophie Allweis por sus comentarios sobre esta publicación de blog y a Tom Small por la visualización.