Introducción

Un objetivo del aprendizaje supervisado es construir un modelo que funcione bien con un conjunto de datos nuevos. El problema es que es posible que no tenga datos nuevos, pero aún puede experimentarlos con un procedimiento como la división tren-prueba-validación.

¿No es interesante ver cómo se desempeña su modelo en un conjunto de datos? ¡Es! Uno de los mejores aspectos de trabajar con dedicación es ver cómo sus esfuerzos se utilizan de manera bien formada para crear un modelo de aprendizaje automático eficiente y generar resultados efectivos.

¿Qué es la división de validación de pruebas de trenes?

La división tren-prueba-validación es fundamental en el aprendizaje automático y el análisis de datos, particularmente durante el desarrollo de modelos. Implica dividir un conjunto de datos en tres subconjuntos: entrenamiento, prueba y validación. La división de pruebas de tren es un proceso de validación de modelos que le permite comprobar cómo se comportaría su modelo con un nuevo conjunto de datos.

La división tren-prueba-validación ayuda a evaluar qué tan bien se generalizará un modelo de aprendizaje automático a datos nuevos e invisibles. También evita el sobreajuste, donde un modelo funciona bien con los datos de entrenamiento pero no logra generalizarse a nuevas instancias. Al utilizar un conjunto de validación, los profesionales pueden ajustar de forma iterativa los parámetros del modelo para lograr un mejor rendimiento con datos invisibles.

Importancia de la división de datos en el aprendizaje automático

La división de datos implica dividir un conjunto de datos en subconjuntos de entrenamiento, validación y prueba. La importancia de la división de datos en el aprendizaje automático cubre los siguientes aspectos:

Capacitación, validación y pruebas

La división de datos divide un conjunto de datos en tres subconjuntos principales: el conjunto de entrenamiento, utilizado para entrenar el modelo; el conjunto de validación, utilizado para rastrear los parámetros del modelo y evitar el sobreajuste; y el conjunto de pruebas, utilizado para comprobar el rendimiento del modelo con nuevos datos. Cada subconjunto tiene un propósito único en el proceso iterativo de desarrollo de un modelo de aprendizaje automático.

Desarrollo y ajuste de modelos

Durante la fase de desarrollo del modelo, el conjunto de entrenamiento es necesario para exponer el algoritmo a varios patrones dentro de los datos. El modelo aprende de este subconjunto, ajustando sus parámetros para minimizar errores. El conjunto de validación es importante durante el seguimiento de hiperparámetros, ya que ayuda a optimizar la configuración del modelo.

Prevención de sobreajuste

El sobreajuste ocurre cuando un modelo aprende bien los datos de entrenamiento, capturando ruido y patrones irrelevantes. El conjunto de validación actúa como un punto de control, permitiendo la detección de sobreajuste. Al evaluar el rendimiento del modelo en un conjunto de datos diferente, puede ajustar la complejidad, las técnicas u otros hiperparámetros del modelo para evitar el sobreajuste y mejorar la generalización.

Evaluación del desempeño

El conjunto de pruebas es esencial para el rendimiento de un modelo de aprendizaje automático. Después del entrenamiento y la validación, el modelo se enfrenta al conjunto de pruebas, que comprueba escenarios del mundo real. Un modelo con buen rendimiento en el conjunto de pruebas indica que se ha adaptado con éxito a datos nuevos e invisibles. Este paso es importante para ganar confianza al implementar el modelo para aplicaciones del mundo real.

Evaluación de sesgos y variaciones

Train Test Validation Split ayuda a comprender la compensación del sesgo. El conjunto de entrenamiento proporciona información sobre el sesgo del modelo, capturando patrones inherentes, mientras que los conjuntos de validación y prueba ayudan a evaluar la varianza, indicando la sensibilidad del modelo a las fluctuaciones en el conjunto de datos. Lograr el equilibrio adecuado entre sesgo y varianza es vital para lograr un modelo que se generalice bien en diferentes conjuntos de datos.

Validación cruzada de robustez

Más allá de una simple división tren-validación-prueba, técnicas como la validación cruzada k-fold mejoran aún más la solidez de los modelos. La validación cruzada implica dividir el conjunto de datos en k subconjuntos, entrenar el modelo en k-1 subconjuntos y validar el restante. Este proceso se repite k veces y se promedian los resultados. La validación cruzada proporciona una comprensión más completa del rendimiento de un modelo en diferentes subconjuntos de datos.

Importancia de la división de datos en el rendimiento del modelo

La importancia de la división de datos en el rendimiento del modelo tiene los siguientes propósitos:

Evaluación de la generalización del modelo.

Los modelos no sólo deben memorizar los datos de entrenamiento sino también generalizar bien. La división de datos permite crear un conjunto de pruebas, lo que proporciona comprobaciones del mundo real para comprobar qué tan bien se desempeña un modelo con datos nuevos. Sin un conjunto de pruebas dedicado, el riesgo de sobreajuste aumenta cuando un modelo se adapta demasiado a los datos de entrenamiento. La división de datos mitiga este riesgo al evaluar las verdaderas capacidades de generalización de un modelo.

Prevención del sobreajuste

El sobreajuste ocurre cuando un modelo se vuelve más complejo y captura ruido o patrones específicos de los datos de entrenamiento, lo que reduce su capacidad de generalización.

Optimización de los hiperparámetros del modelo El seguimiento de un modelo implica ajustar los hiperparámetros para lograr el rendimiento. Este proceso requiere ajustes iterativos basados en el comportamiento del modelo, realizados por un conjunto de validación separado.

Evaluación de fuerza

Un modelo sólido debe funcionar de manera consistente en diferentes conjuntos de datos y escenarios. La división de datos, en particular la validación cruzada de k veces, ayuda a evaluar la solidez de un modelo. Al entrenar y validar diferentes subconjuntos, puede obtener información sobre qué tan bien se generaliza un modelo a diversas distribuciones de datos.

Gestión de compensaciones entre sesgo y varianza

Lograr un equilibrio entre el sesgo y la varianza es crucial para desarrollar modelos que no se ajusten demasiado a los datos. La división de datos permite evaluar el sesgo de un modelo en el conjunto de entrenamiento y su variación en el conjunto de validación o prueba. Esta comprensión es esencial para optimizar la complejidad del modelo.

Comprender la división de datos: entrenar, probar y validar

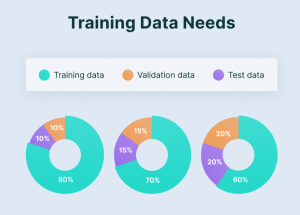

Para fines de entrenamiento y prueba de un modelo, los datos deben dividirse en tres conjuntos de datos diferentes:

El conjunto de entrenamiento

Es el conjunto de datos que se utiliza para entrenar y hacer que el modelo aprenda las características ocultas de los datos. El conjunto de entrenamiento debe tener diferentes entradas para que el modelo se entrene en todas las condiciones y pueda predecir cualquier muestra de datos que pueda aparecer en el futuro.

El conjunto de validación

El conjunto de validación es un conjunto de datos que se utiliza para validar el rendimiento del modelo durante el entrenamiento.

Este proceso de validación brinda información que ayuda a ajustar las configuraciones del modelo. Después de cada época, el modelo se entrena en el conjunto de entrenamiento y la evaluación del modelo se realiza en el conjunto de validación.

La idea principal de dividir el conjunto de datos en un conjunto de validación es evitar que el modelo se vuelva bueno para clasificar las muestras en el conjunto de entrenamiento pero no pueda generalizar y realizar clasificaciones precisas sobre los datos que no ha visto antes.

El conjunto de prueba

El conjunto de prueba es un conjunto de datos que se utiliza para probar el modelo después de completar el entrenamiento. Proporciona un rendimiento del modelo final en términos de exactitud y precisión.

Preprocesamiento y limpieza de datos

El preprocesamiento de datos implica la transformación del conjunto de datos sin procesar a un formato comprensible. El preprocesamiento de datos es una etapa esencial en la minería de datos que ayuda a mejorar la eficiencia de los datos.

Aleatorización en la división de datos

La aleatorización es esencial en el aprendizaje automático, ya que garantiza subconjuntos de capacitación, validación y prueba imparciales. Mezclar aleatoriamente el conjunto de datos antes de realizar la partición minimiza el riesgo de introducir patrones específicos del orden de los datos. Esto evita que los modelos aprendan datos ruidosos según la disposición. La aleatorización mejora la capacidad de generalización de los modelos, haciéndolos robustos en diversas distribuciones de datos. También protege contra posibles sesgos, asegurando que cada subconjunto refleje la diversidad presente en el conjunto de datos general.

División de prueba de tren: cómo

Para realizar una división de prueba de entrenamiento, use bibliotecas como scikit-learn en Python. Importe la función `train_test_split`, especifique el conjunto de datos y establezca el tamaño de la prueba (por ejemplo, 20%). Esta función divide aleatoriamente los datos en conjuntos de entrenamiento y prueba, preservando la distribución de clases o resultados.

Código Python para Train Test Split:

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

#import csvDivisión de validación: cómo

Después de la división entreno y prueba, divida aún más el conjunto de entrenamiento para una división de validación. Esto es crucial para el ajuste del modelo. Nuevamente, use `train_test_split` en los datos de entrenamiento, asignando una porción (por ejemplo, 15%) como conjunto de validación. Esto ayuda a refinar los parámetros del modelo sin tocar el equipo de prueba intacto.

Código Python para división de validación

from sklearn.model_selection import train_test_split

X_train_temp, X_temp, y_train_temp, y_temp = train_test_split(X, y, test_size=0.3, random_state=42)

X_val, X_test, y_val, y_test = train_test_split(X_temp, y_temp, test_size=0.5, random_state=42)

#import csvPrueba de tren dividida para clasificación

En la clasificación, los datos se dividen en dos partes: conjuntos de entrenamiento y prueba. El modelo se entrena en un conjunto de entrenamiento y su rendimiento se examina en un conjunto de prueba. El conjunto de entrenamiento contiene el 80% de los datos, mientras que el conjunto de prueba contiene el 20%.

Ejemplo de datos reales:

from sklearn.model_selection import train_test_split

from sklearn.datasets import load_trivia

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

iris = load_trivia()

X = trivia.data

y = trivia.target

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

model = LogisticRegression()

model.fit(X_train, y_train)

y_pred = model.predict(X_test)

accuracy = accuracy_score(y_test, y_pred)

print(f"Accuracy: {accuracy}")

#import csvProducción

Precisión: 1.0

Regresión de prueba de tren

Divida los conjuntos de datos de regresión en conjuntos de datos de entrenamiento y prueba. Entrene el modelo en función de los datos de entrenamiento y el rendimiento se evalúa en función de los datos de prueba. El objetivo principal es ver qué tan bien se generaliza el modelo al nuevo conjunto de datos.

from sklearn.model_selection import train_test_split

from sklearn.datasets import load_boston

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error

boston = load_boston()

X = boston.data

y = boston.target

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

model = LinearRegression()

model.fit(X_train, y_train)

y_pred = model.predict(X_test)

mse = mean_squared_error(y_test, y_pred)

print(f"Mean Squared Error: {mse}")

#import csvError cuadrático medio: 24.291119474973616

Mejores prácticas en división de datos

- Aleatorización: mezcle los datos aleatoriamente antes de dividirlos para evitar sesgos relacionados con el orden.

- Estratificación: Mantener la distribución de clases en cada división, fundamental para las tareas de clasificación.

- Validación cruzada: emplee una validación cruzada de k veces para una evaluación sólida del modelo, especialmente en conjuntos de datos más pequeños.

Errores comunes a evitar

Los errores comunes que se deben evitar al realizar una división de entrenamiento, prueba y validación son:

- Fuga de datos: Asegúrese de que ninguna información del conjunto de pruebas influya en la capacitación o la validación.

- Ignorar el desequilibrio de clases: Abordar los desequilibrios de clases estratificando las divisiones para mejorar el entrenamiento del modelo

- Pasando por alto la validación cruzada: Depender únicamente de una única división tren-prueba puede sesgar la evaluación del modelo.

Conclusión

Train-Test-Validation Split es una prueba esencial para probar la eficiencia de un modelo de aprendizaje automático. Evalúa diferentes conjuntos de datos para comprobar la precisión del modelo de aprendizaje automático, por lo que sirve como una herramienta imprescindible en el ámbito tecnológico.

Conclusiones clave

- División de Datos Estratégicos:

- Conozca la importancia de dividir los datos en conjuntos de capacitación, pruebas y validación para un desarrollo eficaz de modelos.

- Comprenda las funciones específicas de cada subconjunto para prevenir el sobreajuste y optimizar el rendimiento del modelo.

- Implementación práctica:

- Adquiera las habilidades para implementar divisiones de entrenamiento-prueba-validación utilizando bibliotecas de Python.

- Comprender la importancia de la aleatorización y la estratificación para una evaluación de modelos imparcial y confiable.

- Protegerse contra errores comunes:

- Obtenga información sobre los errores comunes durante la división de datos, como la fuga y el desequilibrio de clases.

- Papel de la validación cruzada para garantizar la solidez y generalización del modelo en diversos conjuntos de datos.

NEWSLETTER

NEWSLETTER