Imagina charlar con un amigo que siempre está allí, nunca cansado y listo para escuchar. En eso se están convirtiendo los chatbots de IA para muchas personas. Desde enviar mensajes de texto hasta hablar en voces calmantes, estos compañeros digitales se están deslizando en nuestra vida diaria. Pero, ¿qué sucede cuando nos apoyamos demasiado en ellos? Un estudio reciente realizado por MIT y OpenAI arroja luz sobre los impactos de diferentes diseños de chatbot y patrones de uso. Los hallazgos ofrecen ideas valiosas para usuarios y desarrolladores de tecnología de IA. ¡Sabemos más al respecto!

El experimento

El estudio fue diseñado para descubrir cómo chatear con IA afecta las emociones y la vida social de las personas. No fue solo una prueba informal: fue un experimento cuidadosamente planeado de cuatro semanas con personas reales y conversaciones reales.

El experimento duró 28 días, cuatro semanas completas. A cada participante se le asignó al azar una de las tres modalidades (texto, voz neutral o voz atractiva) y uno de los tres tipos de conversación (abierto, personal o no personal). Eso hizo nueve combos posibles, como texto con chats personales o voz atractiva con temas no personales. La asignación aleatoria significaba que nadie eligió su configuración; Todo fue casualidad, lo que ayuda a que los resultados sean justos.

Todos los días, los participantes iniciaron sesión y hablaron con su chatbot. Los investigadores rastrearon todo, más de 300,000 mensajes en total. Medieron cuánto tiempo pasaron las personas charlando (llamada “duración diaria”) ya que escribir y hablar toman diferentes cantidades de tiempo. Algunos pegados a los mínimos cinco minutos; Otros fueron mucho más tiempo, hasta casi 28 minutos al día.

Así es como funcionó:

Fuente: <a target="_blank" href="https://www.media.mit.edu/publications/how-ai-and-human-behaviors-shape-psychosocial-effects-of-chatbot-use-a-longitudinal-controlled-study/” target=”_blank” rel=”noreferrer noopener nofollow”>Documento de investigación de MIT y Openai

¿Quién estuvo involucrado?

Los investigadores reunieron 981 adultos, una mezcla de hombres (48.2%) y mujeres (51.8%), con una edad promedio de aproximadamente 40. Estas no eran personas al azar fuera de la calle, eran personas dispuestas a conversar con una IA todos los días durante un mes. La mayoría tenía trabajos (48.7% a tiempo completo), y aproximadamente la mitad había usado un chatbot basado en texto como chatgpt antes, aunque pocos habían probado versiones de voz. Esta mezcla dio una amplia instantánea de personas comunes, no solo geeks tecnológicos o solitarios.

¿Qué usaron?

La IA fue una versión del ChatGPT (GPT-4O) de OpenAi, ajustada para el experimento. Todos los participantes no obtuvieron el mismo chatbot. Los investigadores lo dividieron en tres estilos, o “modalidades”, para ver cómo las diferentes formas de interactuar podrían cambiar las cosas:

- Modalidad de texto: Solo escribiendo, como enviar mensajes de texto a un amigo. Esta fue la versión básica, el grupo de control.

- Modalidad de voz neutral: Una versión de voz con un tono profesional y tranquilo, como un representante de servicio al cliente educado.

- Modalidad de voz atractiva: Una voz más animada, más emocional y expresiva, como un amigo hablador.

Para los modos de voz, utilizaron dos opciones: Ember (sonido masculino) o SOL (sonido femenino) asignados al azar. Las voces no eran solo de sonido; Las instrucciones personalizadas hicieron que la neutral sea formal y la atractiva cálida y receptiva. Esto deja que el equipo probara si la “personalidad” de un chatbot es importante.

¿De qué hablaba la gente?

Las conversaciones no fueron gratuitas para todos. Los participantes recibieron tareas específicas para guiar sus chats, divididos en tres tipos:

- Conversaciones abiertas: Podrían hablar de cualquier cosa como deportes, películas, lo que sea que se haya puesto en la cabeza. Este era el control, imitando cómo las personas podrían usar naturalmente un chatbot.

- Conversaciones personales: Cada día, tenían un aviso para compartir algo personal, como “¿De qué es algo por lo que estás agradecido?” o “Cuéntame sobre un momento difícil”. Esto estaba destinado a imitar a un chatbot complementario, el amable gente recurre para obtener apoyo emocional.

- Conversaciones no personales: Las indicaciones diarias sobre temas neutrales, como “¿Cómo dieron forma a los eventos históricos la tecnología?” Esto fue como usar un chat de asistente general para hechos o ideas.

¿Qué estaban midiendo?

El objetivo era ver cómo estos chats afectaron cuatro grandes sentimientos o comportamientos, llamados “resultados psicosociales”:

- Soledad: Qué aislada o sola se sentía la gente, anotada de 1 (en absoluto) a 4 (mucho).

- Socialización con personas: Cuánto colgaron con humanos reales, anotaron de 0 (ninguno) a 5 (mucho).

- Dependencia emocional de la IA: Cuánto necesitaban el chatbot emocionalmente, como sentirse molesto sin él, anotado de 1 (en absoluto) a 5 (mucho).

- Uso problemático de ai: Los hábitos poco saludables, como obsesionarse con el chatbot, anotaron de 1 (en absoluto) a 5 (mucho).

Los revisaron al inicio (línea de base) y finalizó (Semana 4), con algunos registros semanales. También preguntaron sobre cosas como la confianza en la IA, la edad, el género y los hábitos para ver cómo eso dio forma a los resultados.

La voz cambia cómo nos sentimos

El sonido de una voz puede hacer maravillas. En el estudio, las personas que usaron chatbots basados en la voz, ya sea un tono tranquilo, neutral o uno animado y atractivo, se sintieron menos solos que los que escribían. No es difícil ver por qué. Una voz agrega calor, un toque de presencia que el texto no puede coincidir. Aquellos con un chatbot de voz neutral obtuvieron puntajes más bajos en la soledad y no se unieron tan a la IA. La voz atractiva, con su talento expresivo, funcionó aún mejor: las personas se sentían menos dependientes y menos atrapadas. Es casi como escuchar un tono amistoso que nuestros cerebros se sienten menos solos.

Modalidad de chatbot al controlar los valores iniciales de los resultados psicosociales medidos al comienzo del estudio.

Fuente: <a target="_blank" href="https://www.media.mit.edu/publications/how-ai-and-human-behaviors-shape-psychosocial-effects-of-chatbot-use-a-longitudinal-controlled-study/” target=”_blank” rel=”noreferrer noopener nofollow”>Documento de investigación de MIT y Openai

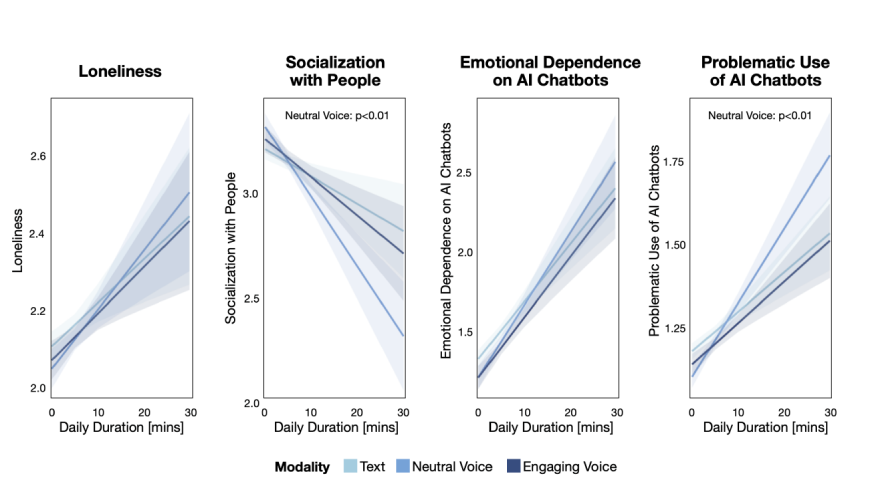

Pero hay un otro lado. Cuando las personas pasaron demasiado tiempo con estos bots de voz, los beneficios comenzaron a caer. La voz neutral, en particular, se volvió agria con un uso pesado. Los participantes terminaron socializando menos con personas reales y mostraron signos de hábitos problemáticos, como verificar la IA con demasiada frecuencia. La voz atractiva se mantuvo mejor, pero incluso su encanto opacó con el uso excesivo. Parece que una voz puede levantarnos, hasta que nos apoyamos demasiado. Entonces podría alejarnos del mundo en lugar de conectarnos a él.

De lo que hablamos también

Lo que dices a un chatbot cambia cómo te afecta. El estudio dividió las conversaciones en tres carriles: chats abiertos donde va todo, conversaciones personales sobre cosas como gratitud o luchas, y temas no personales como la historia o la tecnología. Los resultados fueron sorprendentes. Los chats personales hicieron que la gente se sintiera un poco más solitaria. Compartir pensamientos profundos podría provocar emociones que no se asientan fácilmente. Pero aquí está la ventaja: esos mismos chats redujeron la dependencia emocional de la IA. Es como si la apertura mantuviera el chatbot a lo largo del brazo, no una muleta, solo una tabla de resonancia.

Los chats no personales contaron una historia diferente. Hablar de hechos o ideas aleatorias no provocó soledad, pero enganchó a los usuarios pesados más duro. Cuanto más conversaban sobre cosas seguras a nivel de superficie, más confiaban en la IA. Las conversaciones abiertas aterrizaron en el medio, la gente pasó la mayor parte del tiempo con ellas, promediando seis minutos al día, y los resultados variaron. Es fascinante cómo el tema puede empujarnos más cerca o más de la IA. Las conversaciones personales pueden agitar el alma, mientras que la pequeña charla corre el riesgo de convertirse en un hábito. Lo que elegimos compartir u esconder parece dar forma al enlace.

<h2 class="wp-block-heading" id="h-too-much-time-with-ai-can-backfire”>Demasiado tiempo con IA puede ser contraproducente

El tiempo es un gran jugador aquí. El estudio rastreó cuánto tiempo pasaron las personas con el chatbot cada día. En promedio, fueron unos cinco minutos, apenas un descanso para tomar un café. Pero el rango era salvaje. Algunos se sumergieron por un minuto, otros permanecieron durante casi media hora. El patrón era claro: más tiempo significaba más problemas. La soledad se arrastró a medida que crecía el uso diario. Socializar con personas reales también recibió un éxito, esas largas conversaciones con IA dejaron menos espacio para amigos o familiares. La dependencia emocional subió, y también lo hizo un uso problemático, como sentirse ansioso sin la IA o verificarla compulsivamente.

Fuente: <a target="_blank" href="https://www.media.mit.edu/publications/how-ai-and-human-behaviors-shape-psychosocial-effects-of-chatbot-use-a-longitudinal-controlled-study/” target=”_blank” rel=”noreferrer noopener nofollow”>Documento de investigación de MIT y Openai

No es que el chatbot en sí sea el problema. Al principio, parecía ayudar. En todos los grupos, la soledad disminuyó ligeramente durante las cuatro semanas. Pero cuanto más pesado sea el uso, más las escamas se inclinaron en el otro sentido. Los usuarios de voz comenzaron con una ventaja, menos soledad, menos apego, pero incluso no pudieron escapar del patrón. Demasiado de algo bueno se volvió agrio. Es una advertencia suave: una pequeña IA podría levantarnos, pero muchas cosas podrían pesarnos. Encontrar ese punto dulce se siente crucial.

<h2 class="wp-block-heading" id="h-who-we-are-shapes-how-ai-affects-us”>Quienes somos formas cómo la IA nos afecta

No todos estamos conectados de la misma manera, y eso importa. El estudio cavó en cómo los rasgos de las personas influyeron en su experiencia de chatbot. Los que comenzaron solos se mantuvieron solos o empeoraron. Si ya estaban emocionalmente pegajosos, la IA no solucionó eso; a menudo lo amplificó. La confianza también jugó un papel. Las personas que vieron el chatbot como confiable y cariñoso terminaron más solas y dependientes al final. Es como creer en la IA demasiado hizo que fuera más difícil dejarlo ir.

El género agregó otra capa. Las mujeres, después de cuatro semanas, socializaron menos con personas reales que los hombres. Si la voz de la IA era el género opuesto, como un hombre que escuchaba una voz femenina “sol” o una mujer que escuchaba la soledad y la dependencia de “Ember”. La edad también importaba. Los participantes mayores se inclinaron más emocionalmente en la IA, tal vez buscando una presencia constante. Los hábitos iniciales también establecen la pauta. Los usuarios pesados desde el principio vieron gotas más grandes en la conexión del mundo real. Nuestras peculiaridades confían, género, edad, incluso cuán sociales somos, colorean cómo la IA encaja en nuestras vidas. No se trata solo de la tecnología; se trata de nosotros.

¿Pueden los chatbots ser demasiado buenos para ser humanos?

La voz atractiva brilla, reduciendo la dependencia y el mal uso con su tono cálido. La gente pasó más de seis minutos al día con él, en comparación con los cuatro con texto. Se sintió real, ayudando a las personas con alta dependencia. Pero surgió una paradoja: cuanto más humano, más se apoyó en ella. Los usuarios propensos a los archivos adjuntos se volvieron más solitarios con un gran uso. La voz neutral se enfrentó peor, aislando a los usuarios pesados. Si ai se siente demasiado humano, ¿llena un vacío o lo amplía? La línea es delgada.

<a target="_blank" href="https://www.media.mit.edu/publications/how-ai-and-human-behaviors-shape-psychosocial-effects-of-chatbot-use-a-longitudinal-controlled-study/” target=”_blank” rel=”noreferrer noopener nofollow”>Puede descargar el trabajo de investigación aquí.

Nota final

Este estudio no se trata solo de chatbots … se trata de nosotros. Los investigadores sugieren que los chatbots podrían empujarnos hacia conexiones reales, establecer límites de chat o manejar mejor las emociones. ai refleja nuestros sentimientos, que son poderosos pero arriesgados, haciéndonos eco demasiado bien podría profundizar la soledad. Se necesita más investigación: estudios más largos, usuarios más jóvenes, impactos en la salud mental. ¿Los chatbots pueden preocuparse sin cruzar líneas? Se trata de ajustar la IA en nuestras vidas, no temerlo o alabarla. ¿Qué necesitamos de ellos, una chat rápida o un suplente? Nuestras respuestas podrían revelar más sobre nosotros que nuestra tecnología.

Inicie sesión para continuar leyendo y disfrutando de contenido curado por expertos.

NEWSLETTER

NEWSLETTER