A medida que la IA generativa continúa impulsando la innovación en todas las industrias y en nuestra vida diaria, la necesidad de una IA responsable se ha vuelto cada vez más importante. En AWS, creemos que el éxito a largo plazo de la IA depende de la capacidad de inspirar confianza entre los usuarios, los clientes y la sociedad. Esta creencia está en el centro de nuestro compromiso de larga data con la creación y el uso de la IA de manera responsable. La IA responsable va más allá de mitigar riesgos y alinearse con estándares y regulaciones relevantes. Se trata de generar confianza de manera proactiva y desbloquear el potencial de la IA para impulsar el valor empresarial. Un enfoque integral de la IA responsable permite a las organizaciones innovar con audacia y lograr resultados empresariales transformadores. Nueva articulación <a target="_blank" href="https://www.accenture.com/content/dam/accenture/final/accenture-com/document-3/Accenture-Responsible-ai-From-Risk-Mitigation-to-Value-Creation.pdf” target=”_blank” rel=”noopener”>investigación realizada por Accenture y AWS subraya esto, destacando la IA responsable como un impulsor clave del valor empresarial: impulsando la calidad del producto, la eficiencia operativa, la lealtad del cliente, la percepción de la marca y más. Casi la mitad de las empresas encuestadas reconocen que la IA responsable es fundamental para impulsar el crecimiento de los ingresos relacionados con la IA. ¿Por qué? La IA responsable genera confianza, y la confianza acelera la adopción y la innovación.

Con la confianza como piedra angular de la adopción de la IA, nos complace anunciar en AWS re:Invent 2024 nuevas herramientas, capacidades y recursos de IA responsable que mejoran la seguridad y la transparencia de nuestros servicios y modelos de IA y ayudan a respaldar los propios de los clientes. Viajes responsables de IA.

Tomar medidas proactivas para gestionar los riesgos de la IA y fomentar la confianza y la interoperabilidad

AWS es el primer importante proveedor de servicios en la nube en anunciar la certificación acreditada ISO/IEC 42001 para servicios de IA, que cubre amazon Bedrock, amazon Q Business, amazon Textract y amazon Transcribe. ISO/CEI 42001 es un estándar internacional de sistemas de gestión que describe los requisitos para que las organizaciones gestionen los sistemas de IA de forma responsable durante todo su ciclo de vida. Las normas técnicas, como ISO/IEC 42001, son importantes porque proporcionan un marco común para el desarrollo y la implementación responsable de la IA, fomentando la confianza y la interoperabilidad en un panorama tecnológico cada vez más global e impulsado por la IA. Lograr la certificación ISO/IEC 42001 significa que un tercero independiente ha validado que AWS está tomando medidas proactivas para gestionar los riesgos y oportunidades asociados con el desarrollo, la implementación y la operación de la IA. Con esta certificación, reforzamos nuestro compromiso de brindar servicios de IA que lo ayuden a innovar de manera responsable con IA.

Ampliar las salvaguardias en amazon Bedrock Guardrails para mejorar la transparencia y la seguridad

En abril de 2024, anunciamos la disponibilidad general de amazon Bedrock Guardrails, que facilita la aplicación de comprobaciones de IA responsables y de seguridad para sus aplicaciones de IA de generación. amazon Bedrock Guardrails ofrece protecciones de seguridad líderes en la industria al bloquear hasta un 85 % más de contenido dañino además de las protecciones nativas proporcionadas por los modelos básicos (FM) y al filtrar más del 75 % de las respuestas alucinantes de los modelos mediante comprobaciones de conexión a tierra contextual para la generación aumentada de recuperación (RAG). ) y casos de uso de resumen. La capacidad de implementar estas salvaguardas fue un gran paso adelante para generar confianza en los sistemas de IA. A pesar de los avances en FM, los modelos aún pueden producir alucinaciones, un desafío al que se enfrentan muchos de nuestros clientes. Para casos de uso donde la precisión es crítica, los clientes necesitan el uso de técnicas matemáticamente sólidas y razonamiento explicable para ayudar a generar respuestas FM precisas.

Para abordar esta necesidad, estamos agregando nuevas medidas de seguridad a amazon Bedrock Guardrails para ayudar a prevenir errores factuales debido a alucinaciones de FM y ofrecer pruebas verificables. Con el lanzamiento de las comprobaciones de razonamiento automatizado en amazon Bedrock Guardrails (versión preliminar), AWS se convierte en el primer y único proveedor importante de nube que integra el razonamiento automatizado en nuestras ofertas de IA generativa. Las comprobaciones de razonamiento automatizadas ayudan a prevenir errores fácticos derivados de alucinaciones utilizando procesos de razonamiento y verificación algorítmica basados en la lógica y matemáticas sólidas para verificar la información generada por un modelo, de modo que los resultados se alineen con los hechos proporcionados y no se basen en datos alucinados o inconsistentes. Utilizadas junto con otras técnicas, como ingeniería rápida, RAG y verificaciones de conexión a tierra contextual, las verificaciones de razonamiento automatizado agregan un enfoque más riguroso y verificable para mejorar la precisión de los resultados generados por LLM. Codificar el conocimiento de su dominio en políticas estructuradas ayuda a que sus aplicaciones de IA conversacional brinden información confiable a sus usuarios.

Haga clic en la imagen a continuación para ver una demostración de las comprobaciones de razonamiento automatizado en amazon Bedrock Guardrails.

A medida que las organizaciones utilizan cada vez más aplicaciones con datos multimodales para impulsar el valor empresarial, mejorar la toma de decisiones y mejorar las experiencias de los clientes, la necesidad de filtros de contenido se extiende más allá del texto. amazon Bedrock Guardrails ahora admite la detección de toxicidad multimodal (en versión preliminar) con soporte para contenido de imágenes, lo que ayuda a las organizaciones a detectar y filtrar contenido de imágenes no deseables y potencialmente dañinos, al mismo tiempo que conserva imágenes seguras y relevantes. La detección de toxicidad multimodal ayuda a eliminar el trabajo pesado necesario para crear sus propias protecciones para los datos de imágenes o invertir tiempo en una evaluación manual que puede ser tediosa y propensa a errores. amazon Bedrock Guardrails le ayuda a crear de forma responsable aplicaciones de IA, lo que le ayuda a generar confianza con sus usuarios.

Mejora de las respuestas y la calidad de las aplicaciones de IA generativa con las nuevas capacidades de evaluación de amazon Bedrock

Con más FM de uso general para elegir, las organizaciones ahora tienen una amplia gama de opciones para impulsar sus aplicaciones de IA generativa. Sin embargo, seleccionar el modelo óptimo para un caso de uso específico requiere comparar modelos de manera eficiente en función de la calidad preferida de una organización y las métricas de IA responsables. Si bien la evaluación es una parte importante para generar confianza y transparencia, exige mucho tiempo, experiencia y recursos para cada nuevo caso de uso, lo que dificulta elegir el modelo que brinde la experiencia del cliente más precisa y segura. amazon Bedrock Assessments aborda esto ayudándolo a evaluar, comparar y seleccionar los mejores FM para su caso de uso. Ahora puede utilizar un LLM como juez (en versión preliminar) para evaluaciones de modelos para realizar pruebas y evaluar otros modelos con calidad similar a la humana en su conjunto de datos. Puede elegir entre LLM alojados en amazon Bedrock para ser juez, con una variedad de métricas de IA responsables y de calidad, como corrección, integridad y nocividad. También puede traer su propio conjunto de datos para personalizar la evaluación con sus datos y comparar los resultados entre trabajos de evaluación para tomar decisiones más rápido. Anteriormente, podía elegir entre la evaluación de modelos basada en humanos y la evaluación automática con coincidencia exacta de cadenas y otras métricas tradicionales de procesamiento del lenguaje natural (PLN). Estos métodos, aunque rápidos, no proporcionaron una fuerte correlación con los evaluadores humanos. Ahora, con LLM-as-a-juez, puede obtener una calidad de evaluación similar a la humana a un costo mucho menor que las evaluaciones completas basadas en humanos y, al mismo tiempo, ahorrar hasta semanas de tiempo. Muchas organizaciones todavía quieren que la evaluación final la realicen anotadores humanos expertos. Para ello, amazon Bedrock todavía ofrece evaluaciones completas basadas en humanos con la opción de traer su propia fuerza laboral o hacer que AWS administre su evaluación personalizada.

Para equipar a los FM con información actualizada y patentada, las organizaciones utilizan RAG, una técnica que obtiene datos de fuentes de datos de la empresa y enriquece el mensaje para proporcionar respuestas más relevantes y precisas. Sin embargo, evaluar y optimizar las aplicaciones RAG puede resultar un desafío debido a la complejidad de optimizar los componentes de recuperación y generación. Para abordar esto, introdujimos soporte de evaluación RAG en amazon Bedrock Knowledge Bases (en versión preliminar). Esta nueva capacidad de evaluación ahora le permite evaluar y optimizar las aplicaciones RAG de manera conveniente y rápida, justo donde ya residen sus datos y LLM. Impulsadas por la tecnología LLM como juez, las evaluaciones RAG ofrecen una selección de varios modelos y métricas de jueces, como relevancia del contexto, cobertura del contexto, corrección y fidelidad (detección de alucinaciones). Esta perfecta integración promueve evaluaciones periódicas, fomentando una cultura de mejora continua y transparencia en el desarrollo de aplicaciones de IA. Al ahorrar costos y tiempo en comparación con las evaluaciones basadas en humanos, estas herramientas permiten a las organizaciones mejorar sus aplicaciones de IA, generando confianza a través de una mejora constante.

Tanto el modelo como las capacidades de evaluación de RAG proporcionan explicaciones en lenguaje natural para cada puntuación en el archivo de salida y en la Consola de administración de AWS. Las puntuaciones están normalizadas de 0 a 1 para facilitar la interpretación. Las rúbricas se publican en su totalidad con las indicaciones del juez en la documentación para que los no científicos puedan entender cómo se obtienen las puntuaciones. Para obtener más información sobre las capacidades de evaluación de modelos y RAG, consulte el blog de noticias.

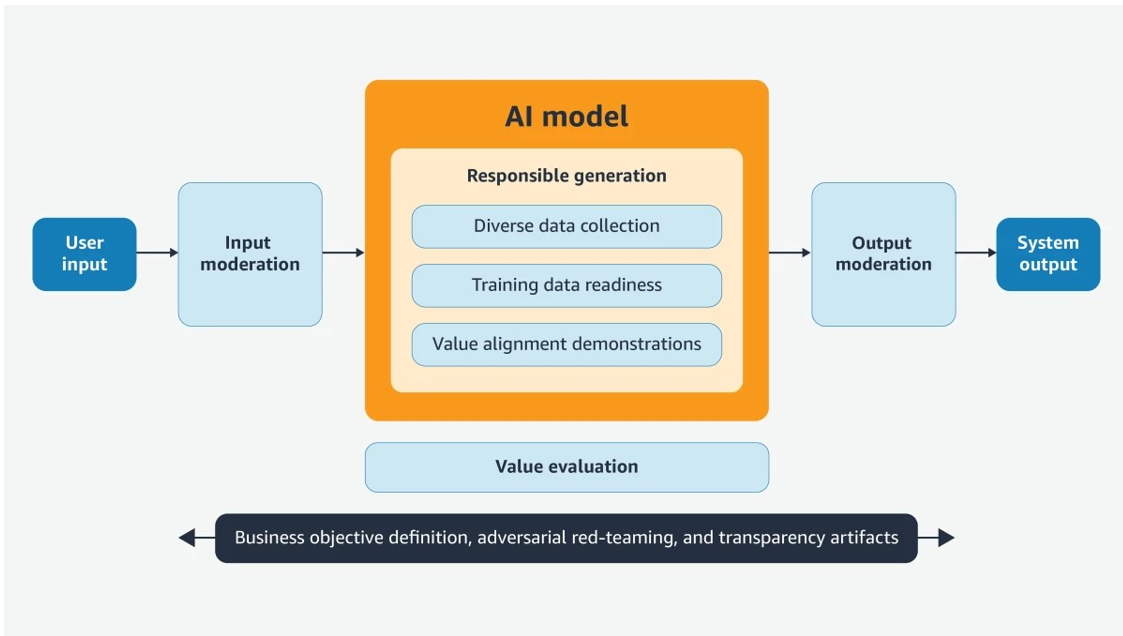

Presentamos amazon Nova, creado con IA responsable como núcleo

amazon Nova es una nueva generación de FM de última generación que ofrece inteligencia de vanguardia y una relación precio-rendimiento líder en la industria. Los amazon Nova FM incorporan medidas de seguridad integradas para detectar y eliminar contenido dañino de los datos, rechazar entradas de usuario inapropiadas y filtrar resultados de modelos. Operativizamos nuestras dimensiones de IA responsable en una serie de objetivos de diseño que guían nuestra toma de decisiones a lo largo del ciclo de vida del desarrollo del modelo, desde la recopilación de datos inicial y el entrenamiento previo hasta la alineación del modelo y la implementación de mitigaciones del tiempo de ejecución posterior a la implementación. amazon Nova Canvas y amazon Nova Reel vienen con controles para respaldar las necesidades de seguridad y propiedad intelectual con IA responsable. Esto incluye marcas de agua, moderación de contenido y compatibilidad con C2PA (disponible en amazon Nova Canvas) para agregar metadatos de forma predeterminada a las imágenes generadas. Las medidas de seguridad de amazon para combatir la difusión de información errónea, material de abuso sexual infantil (CSAM) y riesgos químicos, biológicos, radiológicos o nucleares (CBRN) también se extienden a los modelos amazon Nova. Para obtener más información sobre cómo se creó amazon Nova de manera responsable, lea el <a target="_blank" href="https://www.amazon.science/blog/amazon-nova-and-our-commitment-to-responsible-ai” target=”_blank” rel=”noopener”>Blog de ciencia amazónica.

Mejorar la transparencia con nuevos recursos para promover la IA generativa responsable

En re:Invent 2024, anunciamos la disponibilidad de nuevas tarjetas de servicio de IA de AWS para amazon Nova Reel, amazon Canvas, amazon Nova Micro, Lite y Pro, amazon Titan Image Generator y amazon Titan Text Embeddings para aumentar la transparencia de los FM de amazon. Estas tarjetas brindan información completa sobre los casos de uso previstos, las limitaciones, las opciones de diseño de IA responsable y las mejores prácticas para la implementación y optimización del rendimiento. Un componente clave de la documentación de IA responsable de amazon, las tarjetas de servicio de IA ofrecen a los clientes y a la comunidad de IA en general un recurso centralizado para comprender el proceso de desarrollo que llevamos a cabo para desarrollar nuestros servicios de una manera responsable que aborde la equidad, la explicabilidad, la privacidad y la seguridad, y la controlabilidad. , veracidad y solidez, gobernanza y transparencia. A medida que la IA generativa continúa creciendo y evolucionando, la transparencia sobre cómo se desarrolla, prueba y utiliza la tecnología será un componente vital para ganarse la confianza tanto de las organizaciones como de sus clientes. Puede explorar las 16 tarjetas de servicios de IA sobre herramientas y recursos de IA responsables.

También actualizamos el <a target="_blank" href="https://d1.awsstatic.com/products/generative-ai/responsbile-ai/AWS-Responsible-Use-of-ai-Guide-Final.pdf” target=”_blank” rel=”noopener”>Guía de uso responsable de la IA de AWS. Este documento ofrece consideraciones para diseñar, desarrollar, implementar y operar sistemas de IA de manera responsable, basándose en nuestros amplios aprendizajes y experiencia en IA. Fue escrito teniendo en mente un conjunto diverso de partes interesadas y perspectivas de la IA, incluidos, entre otros, constructores, tomadores de decisiones y usuarios finales. En AWS, estamos comprometidos a continuar brindando recursos de transparencia como estos a la comunidad en general, y a repetir y recopilar comentarios sobre las mejores maneras de avanzar.

Ofreciendo innovación revolucionaria con confianza a la vanguardia

En AWS, nos dedicamos a fomentar la confianza en la IA, empoderando a organizaciones de todos los tamaños para crear y utilizar la IA de manera efectiva y responsable. Estamos entusiasmados con las innovaciones de IA responsable anunciadas en re:Invent esta semana. Desde nuevas salvaguardas y técnicas de evaluación en amazon Bedrock hasta amazon Nova FM de última generación, pasando por el fomento de la confianza y la transparencia con la certificación ISO/IEC 42001 y las nuevas tarjetas de servicio de IA de AWS, tiene más herramientas, recursos y protecciones integradas para ayudarle a innovar de manera responsable y generar valor con IA generativa.

Le animamos a explorar estas nuevas herramientas y recursos:

Sobre el autor

Dr. Baskar Sridharan es vicepresidente de IA/ML y servicios e infraestructura de datos, donde supervisa la dirección estratégica y el desarrollo de servicios clave, incluidos Bedrock, SageMaker y plataformas de datos esenciales como EMR, Athena y Glue.

Dr. Baskar Sridharan es vicepresidente de IA/ML y servicios e infraestructura de datos, donde supervisa la dirección estratégica y el desarrollo de servicios clave, incluidos Bedrock, SageMaker y plataformas de datos esenciales como EMR, Athena y Glue.

NEWSLETTER

NEWSLETTER