Las aplicaciones industriales del aprendizaje automático se componen comúnmente de varios elementos que tienen diferentes modalidades de datos o distribuciones de funciones. Gráficos heterogéneos (HG) ofrecen una vista unificada de estos sistemas de datos multimodales al definir múltiples tipos de nodos (para cada tipo de datos) y bordes (para la relación entre elementos de datos). Por ejemplo, las redes de comercio electrónico pueden tener [user, product, review] nodos o plataformas de video pueden tener [channel, user, video, comment] nodos. Redes neuronales de grafos heterogéneos (HGNN) aprenden incrustaciones de nodos que resumen las relaciones de cada nodo en un vector. Sin embargo, en los HG del mundo real, a menudo hay un problema de desequilibrio de etiquetas entre los diferentes tipos de nodos. Esto significa que los tipos de nodos con escasez de etiquetas no pueden explotar los HGNN, lo que dificulta la aplicabilidad más amplia de los HGNN.

En “Aprendizaje de transferencia de tiro cero dentro de un gráfico heterogéneo a través de redes de transferencia de conocimiento”, presentado en NeurIPS 2022, proponemos un modelo llamado Red de transferencia de conocimiento (KTN), que transfiere conocimiento de tipos de nodos con etiquetas abundantes a tipos de nodos sin etiquetas utilizando la rica información relacional proporcionada en un HG. Describimos cómo entrenamos previamente un modelo HGNN sin necesidad de ajustes. Los KTN superan las líneas de base de aprendizaje de transferencia de última generación hasta en un 140 % en tareas de aprendizaje de disparo cero y se pueden usar para mejorar muchos modelos HGNN existentes en estas tareas en un 24 % (o más).

|

| Los KTN transforman las etiquetas a partir de un tipo de información (cuadrícula) a través de un gráfico a otro tipo (estrellas). |

¿Qué es un gráfico heterogéneo?

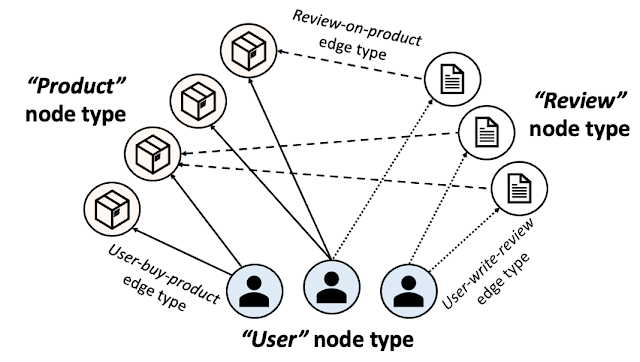

Un HG se compone de múltiples tipos de nodos y bordes. La siguiente figura muestra una red de comercio electrónico presentada como un HG. En el comercio electrónico, los “usuarios” compran “productos” y escriben “reseñas”. Un HG presenta este ecosistema usando tres tipos de nodos [user, product, review] y tres tipos de borde [user-buy-product, user-write-review, review-on-product]. Los productos, usuarios y reseñas individuales se presentan luego como nodos y sus relaciones como bordes en el HG con los tipos de nodo y borde correspondientes.

|

| Gráfico heterogéneo de comercio electrónico. |

Además de toda la información de conectividad, los HG se dan comúnmente con atributos del nodo de entrada que resumen la información de cada nodo. Los atributos de los nodos de entrada pueden tener diferentes modalidades en diferentes tipos de nodos. Por ejemplo, las imágenes de los productos se pueden proporcionar como atributos de nodo de entrada para los nodos de productos, mientras que el texto se puede proporcionar como atributos de entrada para los nodos de revisión. Etiquetas de nodo (por ejemplo, la categoría de cada producto o la categoría que más le interesa a cada usuario) son las que queremos predecir en cada nodo.

HGNN y problemas de escasez de etiquetas

Cálculo de HGNN incrustaciones de nodos que resumen las estructuras locales de cada nodo (incluyendo el nodo y la información de su vecino). Estas incrustaciones de nodos son utilizadas por un clasificador para predecir la etiqueta de cada nodo. Para entrenar un modelo HGNN y un clasificador para predecir etiquetas para un tipo de nodo específico, necesitamos una buena cantidad de etiquetas para el tipo.

Un problema común en las aplicaciones industriales del aprendizaje profundo es la escasez de etiquetas y, con sus diversos tipos de nodos, es aún más probable que los HGNN enfrenten este desafío. Por ejemplo, los tipos de nodos de contenido disponibles públicamente (p. ej., nodos de productos) están abundantemente etiquetados, mientras que las etiquetas para los nodos de cuentas o usuarios pueden no estar disponibles debido a restricciones de privacidad. Esto significa que en la mayoría de los entornos de entrenamiento estándar, los modelos HGNN solo pueden aprender a hacer buenas inferencias para unos pocos tipos de nodos con abundantes etiquetas y, por lo general, no pueden hacer ninguna inferencia para ningún tipo de nodo restante (dada la ausencia de etiquetas para ellos).

Transferir el aprendizaje en grafos heterogéneos

Aprendizaje de transferencia de tiro cero es una técnica utilizada para mejorar el rendimiento de un modelo en un objetivo dominio sin etiquetas utilizando el conocimiento aprendido por el modelo de otro relacionado fuente dominio con datos adecuadamente etiquetados. Para aplicar el aprendizaje de transferencia para resolver este problema de escasez de etiquetas para ciertos tipos de nodos en HG, el dominio objetivo serían los tipos de nodos con etiqueta cero. Entonces, ¿cuál sería el dominio de origen? Anterior trabajar comúnmente establece el dominio de origen como el mismo tipo de nodos ubicados en un HG diferente, suponiendo que esos nodos estén abundantemente etiquetados. Este aprendizaje de transferencia de gráfico a gráfico El enfoque entrena previamente un modelo HGNN en el HG externo y luego ejecuta el modelo en el HG original (escasa etiqueta).

Sin embargo, estos enfoques no son aplicables en muchos escenarios del mundo real por tres razones. En primer lugar, cualquier HG externo que pudiera usarse en un entorno de aprendizaje de transferencia de gráfico a gráfico casi seguramente sería propiedad, por lo tanto, es probable que no esté disponible. En segundo lugar, incluso si los profesionales pudieran obtener acceso a un HG externo, es poco probable que el distribución de esa fuente HG coincidiría con su objetivo HG lo suficientemente bien como para aplicar el aprendizaje de transferencia. Finalmente, los tipos de nodos que sufren de escasez de etiquetas es probable que sufran el mismo problema en otros HG (por ejemplo, problemas de privacidad en los nodos de usuario).

Nuestro enfoque: transferir el aprendizaje entre tipos de nodos dentro de un gráfico heterogéneo

Aquí, arrojamos luz sobre un dominio fuente más práctico, otros tipos de nodos con abundantes etiquetas ubicadas en el mismo HG. En lugar de usar HG adicionales, transferimos conocimiento dentro de un solo HG (que se supone que es propiedad total de los profesionales) a través de diferentes tipos de nodos. Más específicamente, entrenamos previamente un modelo HGNN y un clasificador en un tipo de nodo abundante en etiquetas (origen), luego reutilizamos los modelos en los tipos de nodos sin etiquetas (objetivo) ubicados en el mismo HG sin ajustes adicionales. El único requisito es que los tipos de nodos de origen y de destino compartan el mismo conjunto de etiquetas (p. ej., en el HG de comercio electrónico, los nodos de productos tienen un conjunto de etiquetas que describe las categorías de productos y los nodos de usuario comparten el mismo conjunto de etiquetas que describen sus categorías de compras favoritas) .

¿Por qué es desafiante?

Desafortunadamente, no podemos reutilizar directamente el HGNN y el clasificador previamente entrenados en el tipo de nodo de destino. Una característica crucial de las arquitecturas HGNN es que están compuestas por módulos especializados para cada tipo de nodo para aprender completamente la multiplicidad de HG. Los HGNN usan distintos conjuntos de módulos para calcular las incrustaciones para cada tipo de nodo. En la siguiente figura, los módulos de color azul y rojo se utilizan para calcular las incrustaciones de nodos para los tipos de nodos de origen y de destino, respectivamente.

|

| Los HGNN se componen de módulos especializados para cada tipo de nodo y utilizan distintos conjuntos de módulos para calcular las incrustaciones de diferentes tipos de nodos. Se pueden encontrar más detalles en el papel. |

Mientras que los HGNN se entrenan previamente en el tipo de nodo de origen, los módulos específicos de la fuente en los HGNN están bien entrenados, sin embargo, los módulos específicos del objetivo están poco entrenados, ya que solo tienen una pequeña cantidad de gradientes que fluyen hacia ellos. Esto se muestra a continuación, donde vemos que el norma L2 de gradientes para los tipos de nodos de destino (es decir, Mtt) son mucho menores que para los tipos de fuente (es decir, Mss). En este caso, un modelo HGNN genera incrustaciones de nodos deficientes para el tipo de nodo de destino, lo que da como resultado un desempeño deficiente de la tarea.

|

KTN: aprendizaje de transferencia de tipo cruzado entrenable para HGNN

Nuestro trabajo se centra en transformar las incrustaciones de nodos de destino (pobres) calculadas por un modelo HGNN previamente entrenado para seguir la distribución de las incrustaciones de nodos de origen. Luego, el clasificador, entrenado previamente en el tipo de nodo de origen, se puede reutilizar para el objetivo tipo de nodo. ¿Cómo podemos mapear las incorporaciones del nodo de destino al dominio de origen? Para responder a esta pregunta, investigamos cómo los HGNN calculan las incrustaciones de nodos para conocer la relación entre las distribuciones de origen y destino.

Los HGNN agregan incrustaciones de nodos conectados para aumentar las incrustaciones de un nodo de destino en cada capa. En otras palabras, las incorporaciones de nodos para los tipos de nodos de origen y de destino se actualizan utilizando la misma entrada: las incorporaciones de nodos de la capa anterior de cualquier tipo de nodo conectado. Esto significa que se pueden representar entre sí. Probamos esta relación teóricamente y encontramos que hay una matriz de mapeo (definida por parámetros HGNN) desde el dominio de destino al dominio de origen (más detalles en el Teorema 1 en el papel). Con base en este teorema, introducimos un auxiliar red neuronalal que nos referiremos como un Red de Transferencia de Conocimiento (KTN), que recibe las incorporaciones del nodo de destino y luego las transforma multiplicándolas con una matriz de mapeo (entrenable). Luego definimos un regularizador que se minimiza junto con la pérdida de rendimiento en la fase previa al entrenamiento para entrenar el KTN. En el momento de la prueba, asignamos las incrustaciones de destino calculadas desde el HGNN preentrenado al dominio de origen utilizando el KTN entrenado para la clasificación.

Resultados experimentales

Para examinar la efectividad de los KTN, ejecutamos 18 tareas de aprendizaje de transferencia de disparo cero diferentes en dos gráficos heterogéneos públicos, Abrir Gráfico Académico y publicado. Comparamos KTN con ocho métodos de aprendizaje de transferencia de última generación (Y, ENE, ENTONCES, CDAN, CDAN-E, WDGRL, LP, EP). Como se muestra a continuación, KTN supera constantemente todas las líneas base en todas las tareas, superando las líneas base de transferencia de aprendizaje hasta en un 140% (según lo medido por Ganancia acumulada descontada normalizadauna métrica de clasificación).

|

|

| Aprendizaje de transferencia de disparo cero en Open Academic Graph (OAG-CS) y conjuntos de datos de Pubmed. Los colores representan diferentes categorías de referencias de aprendizaje de transferencia con las que se comparan los resultados. Amarillo: Usar propiedades estadísticas (p. ej., media, varianza) de las distribuciones. Verde: Usar modelos adversarios para transferir conocimientos. Naranja: Transferir conocimiento directamente a través de la estructura gráfica usando propagación de etiquetas. |

Lo que es más importante, KTN se puede aplicar a casi todos los modelos HGNN que tienen parámetros específicos del tipo de borde y nodo y mejoran su rendimiento de disparo cero en los dominios de destino. Como se muestra a continuación, KTN mejora la precisión en los tipos de nodos con etiqueta cero en seis modelos HGNN diferentes (R-GCN, ÉL, HGT, MAGNÍFICO, MPNN, H-MPNN) hasta en un 190%.

|

| KTN se puede aplicar a seis modelos HGNN diferentes y mejorar su rendimiento de disparo cero en los dominios de destino. |

comida para llevar

Varios ecosistemas en la industria se pueden presentar como gráficos heterogéneos. Los HGNN resumen información gráfica heterogénea en representaciones efectivas. Sin embargo, los problemas de escasez de etiquetas en ciertos tipos de nodos impiden la aplicación más amplia de HGNN. En esta publicación, presentamos KTN, el primer método de aprendizaje de transferencia de tipo cruzado diseñado para HGNN. Con KTN, podemos aprovechar al máximo la riqueza de gráficos heterogéneos a través de HGNN, independientemente de la escasez de etiquetas. Ver el papel para más detalles.

Agradecimientos

Este documento es un trabajo conjunto con nuestros coautores John Palowitch (Google Research), Dustin Zelle (Google Research), Ziniu Hu (pasante, Google Research) y Russ Salakhutdinov (CMU). Agradecemos a Tom Small por crear la figura animada en esta publicación de blog.

NEWSLETTER

NEWSLETTER