En esta publicación, analizamos cómo la inteligencia artificial (IA) generativa puede ayudar a los miembros de los planes de seguro médico a obtener la información que necesitan. A muchos beneficiarios de planes de seguro médico les resulta difícil navegar por los complejos portales para miembros que ofrecen sus planes de seguro. Estos portales suelen requerir múltiples clics, filtros y búsquedas para encontrar información específica sobre sus beneficios, deducibles, historial de reclamos y otros detalles importantes. Esto puede generar insatisfacción, confusión y un aumento de las llamadas al servicio de atención al cliente, lo que da como resultado una experiencia deficiente tanto para los miembros como para los proveedores.

El problema surge de la incapacidad de las interfaces de usuario tradicionales para comprender y responder a las consultas en lenguaje natural de manera eficaz. Los miembros se ven obligados a aprender y adaptarse a la estructura y la terminología del sistema, en lugar de que el sistema esté diseñado para comprender sus preguntas en lenguaje natural y brindar información relevante sin problemas. La tecnología de IA generativa, como los asistentes de IA conversacionales, puede resolver potencialmente este problema al permitir que los miembros hagan preguntas con sus propias palabras y reciban respuestas precisas y personalizadas. Al integrar la IA generativa impulsada por amazon Bedrock y los servicios de datos de AWS diseñados específicamente para este fin, como amazon Relational Database Service (amazon RDS), en los portales de miembros, los pagadores y los planes de atención médica pueden permitir a sus miembros encontrar la información que necesitan de manera rápida y sin esfuerzo, sin navegar por varias páginas ni depender en gran medida de los representantes de servicio al cliente. amazon Bedrock es un servicio completamente administrado que ofrece una selección de modelos base (FM) de alto rendimiento de empresas de IA líderes como AI21 Labs, Anthropic, Cohere, Meta, Stability ai y amazon a través de una API unificada, junto con un amplio conjunto de capacidades para crear aplicaciones de IA generativa con seguridad, privacidad e IA responsable.

La solución presentada en este artículo no solo mejora la experiencia de los miembros al ofrecer una interfaz más intuitiva y fácil de usar, sino que también tiene el potencial de reducir los volúmenes de llamadas y los costos operativos para los aseguradores y los planes de atención médica. Al abordar este problema, las organizaciones de atención médica pueden mejorar la satisfacción de los miembros, reducir la pérdida de clientes y optimizar sus operaciones, lo que en última instancia conduce a una mayor eficiencia y ahorro de costos.

Descripción general de la solución

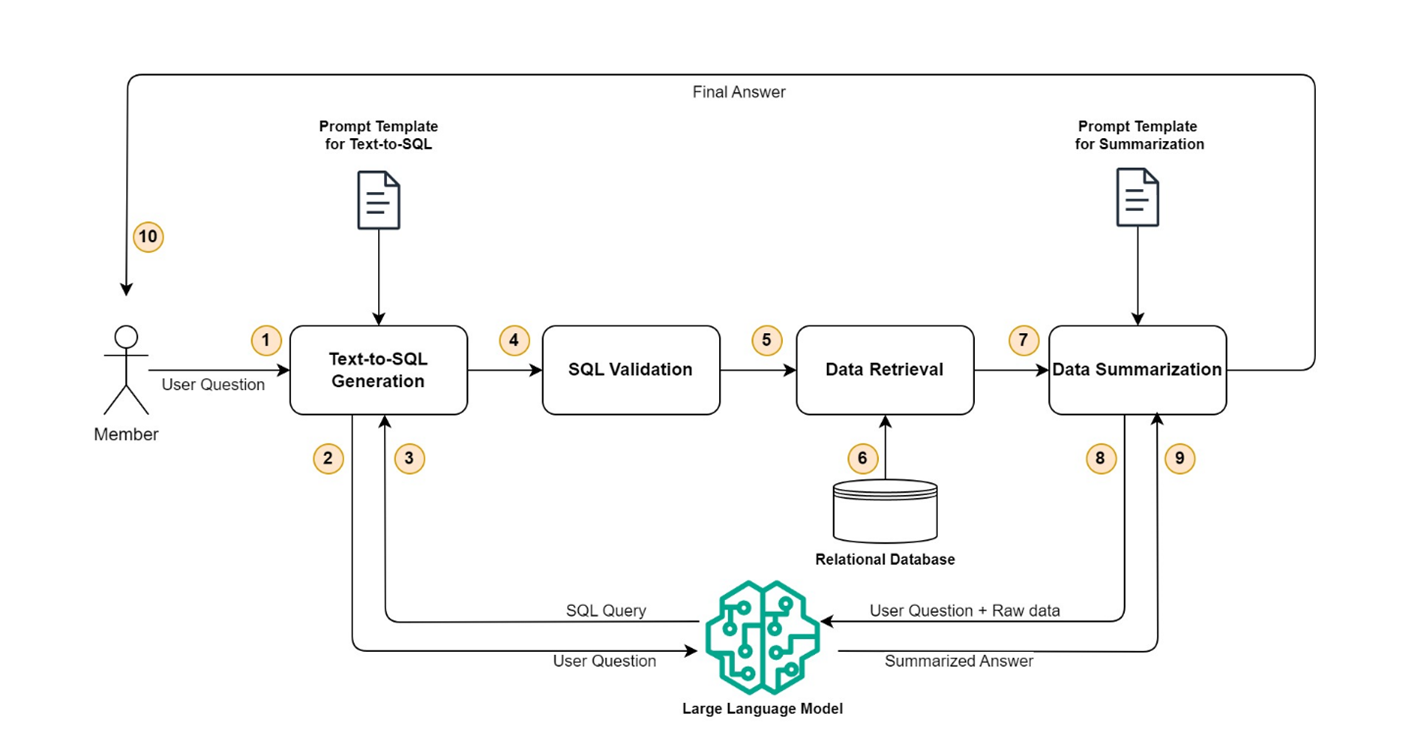

En esta sección, profundizamos para mostrar cómo se puede utilizar la IA generativa y los modelos de lenguaje extenso (LLM) para mejorar la experiencia de los miembros mediante la transición de una búsqueda de reclamaciones basada en filtros tradicional a una búsqueda basada en indicaciones, que permite a los miembros hacer preguntas en lenguaje natural y obtener las reclamaciones o los detalles de los beneficios deseados. Desde una perspectiva amplia, la solución completa se puede dividir en cuatro pasos distintos: generación de texto a SQL, validación de SQL, recuperación de datos y resumen de datos. El siguiente diagrama ilustra este flujo de trabajo.

Vamos a profundizar en cada paso uno por uno.

Generación de texto a SQL

Este paso toma las preguntas del usuario como entrada y las convierte en una consulta SQL que se puede utilizar para recuperar la información relacionada con el reclamo o el beneficio de una base de datos relacional. Se utiliza una plantilla de solicitud preconfigurada para llamar al LLM y generar una consulta SQL válida. La plantilla de solicitud contiene la pregunta del usuario, las instrucciones y el esquema de la base de datos junto con elementos de datos clave, como el ID del miembro y el ID del plan, que son necesarios para limitar el conjunto de resultados de la consulta.

Validación SQL

Este paso valida la consulta SQL generada en el paso anterior y garantiza que esté completa y sea segura para ejecutarse en una base de datos relacional. Algunas de las comprobaciones que se realizan incluyen:

- No hay operaciones de eliminación, eliminación, actualización o inserción presentes en la consulta generada

- La consulta comienza con select

- La cláusula WHERE está presente

- Las condiciones clave están presentes en la cláusula WHERE (por ejemplo, member-id = “78687576501” o member-id como “786875765%%”)

- La longitud de la consulta (longitud de la cadena) está dentro del rango esperado (por ejemplo, no más de 250 caracteres)

- La longitud de la pregunta del usuario original está dentro del rango esperado (por ejemplo, no más de 200 caracteres)

Si una verificación falla, la consulta no se ejecuta; en su lugar, se envía un mensaje fácil de usar que sugiere que el usuario se comunique con el servicio de atención al cliente.

Recuperación de datos

Una vez validada la consulta, se utiliza para recuperar los datos de reclamaciones o beneficios de una base de datos relacional. Los datos recuperados se convierten en un objeto JSON, que se utiliza en el siguiente paso para crear la respuesta final mediante un LLM. Este paso también comprueba si la consulta no devuelve datos o si devuelve demasiadas filas. En ambos casos, se envía un mensaje fácil de usar al usuario, sugiriendo que proporcione más detalles.

Resumen de datos

Por último, el objeto JSON recuperado en el paso de recuperación de datos junto con la pregunta del usuario se envía a LLM para obtener la respuesta resumida. Se utiliza una plantilla de solicitud preconfigurada para llamar a LLM y generar una respuesta resumida fácil de usar a la pregunta original.

Arquitectura

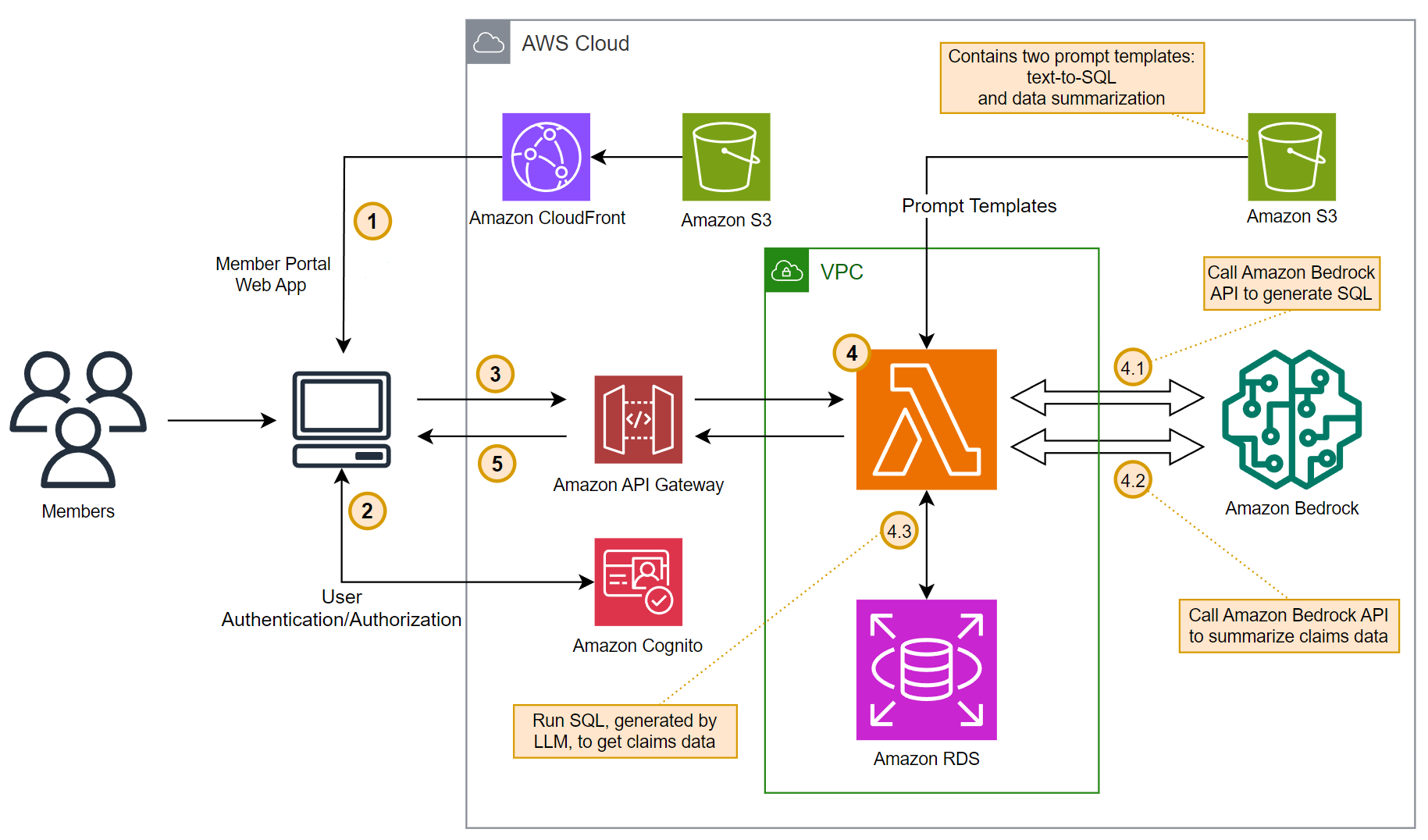

La solución utiliza amazon API Gateway, AWS Lambda, amazon RDS, amazon Bedrock y Soneto Claude 3 antrópico en amazon Bedrock para implementar el backend de la aplicación. El backend se puede integrar con una aplicación web o un portal existente, pero para el propósito de esta publicación, usamos una aplicación de página única (SPA) alojada en amazon Simple Storage Service (amazon S3) para el frontend y amazon Cognito para la autenticación y autorización. El siguiente diagrama ilustra la arquitectura de la solución.

El flujo de trabajo consta de los siguientes pasos:

- Una aplicación de página única (SPA) se aloja mediante amazon S3 y se carga en el navegador del usuario final mediante amazon CloudFront.

- La autenticación y autorización del usuario se realiza mediante amazon Cognito.

- Después de una autenticación exitosa, se invoca una API REST alojada en API Gateway.

- La función Lambda, expuesta como una API REST mediante API Gateway, organiza la lógica para realizar los pasos funcionales: generación de texto a SQL, validación de SQL, recuperación de datos y resumen de datos. El punto de conexión de la API de amazon Bedrock se utiliza para invocar Anthropic Claude 3 Sonnet LLM. Los datos de reclamaciones y beneficios se almacenan en una base de datos PostgreSQL alojada en amazon RDS. Otro depósito S3 se utiliza para almacenar plantillas de solicitud que se utilizarán para la generación de SQL y los resúmenes de datos. Esta solución utiliza dos plantillas de solicitud distintas:

- La plantilla de solicitud de texto a SQL contiene la pregunta del usuario, las instrucciones, el esquema de la base de datos junto con elementos de datos clave, como el ID del miembro y el ID del plan, que son necesarios para limitar el conjunto de resultados de la consulta.

- La plantilla de solicitud de resumen de datos contiene la pregunta del usuario, datos sin procesar recuperados de la base de datos relacional e instrucciones para generar una respuesta resumida fácil de usar a la pregunta original.

- Finalmente, la respuesta resumida generada por el LLM se envía de vuelta a la aplicación web que se ejecuta en el navegador del usuario mediante API Gateway.

Plantillas de muestra de indicaciones

En esta sección presentamos algunos ejemplos de plantillas de indicaciones.

El siguiente es un ejemplo de una plantilla de solicitud de texto a SQL:

El {text1} y {text2} Los elementos de datos se reemplazarán de manera programática para completar la ID del miembro conectado y la pregunta del usuario. Además, se pueden agregar más ejemplos para ayudar al LLM a generar SQL adecuados.

El siguiente es un ejemplo de una plantilla de solicitud de resumen de datos:

El {text1}, {text2}y {text3} Los elementos de datos se reemplazarán mediante programación para completar la pregunta del usuario, la consulta SQL generada en el paso anterior y los datos formateados en JSON y recuperados de amazon RDS.

Seguridad

amazon Bedrock está dentro del alcance de estándares de cumplimiento comunes, como Service and Organization Control (SOC), International Organization for Standardization (ISO) y Health Insurance Portability and Accountability Act (HIPAA), y puede utilizar amazon Bedrock de conformidad con el Reglamento General de Protección de Datos (GDPR). El servicio le permite implementar y utilizar LLM en un entorno seguro y controlado. Los puntos de conexión de amazon Bedrock VPC con tecnología de AWS PrivateLink le permiten establecer una conexión privada entre la nube privada virtual (VPC) de su cuenta y la cuenta de servicio de amazon Bedrock. Permite que las instancias de VPC se comuniquen con los recursos de servicio sin necesidad de direcciones IP públicas. Definimos las diferentes cuentas de la siguiente manera:

- Cuenta de cliente – Esta es la cuenta que posee el cliente, donde administra sus recursos de AWS, como instancias de RDS y funciones Lambda, e interactúa con los LLM alojados en amazon Bedrock de forma segura mediante puntos de conexión de amazon Bedrock VPC. Debe administrar el acceso a los recursos y bases de datos de amazon RDS siguiendo las prácticas recomendadas de seguridad para amazon RDS.

- Cuentas de servicio de amazon Bedrock – Este conjunto de cuentas es propiedad y está operado por el equipo de servicio de amazon Bedrock, que aloja las distintas API de servicio y la infraestructura de servicio relacionada.

- Cuentas de implementación de modelos – Los LLM que ofrecen varios proveedores están alojados y operados por AWS en cuentas separadas dedicadas a la implementación de modelos. amazon Bedrock mantiene el control y la propiedad totales de las cuentas de implementación de modelos, lo que garantiza que ningún proveedor de LLM tenga acceso a estas cuentas.

Cuando un cliente interactúa con amazon Bedrock, sus solicitudes se enrutan a través de una conexión de red segura a la cuenta de servicio de amazon Bedrock. Luego, amazon Bedrock determina qué cuenta de implementación de modelo aloja el modelo LLM solicitado por el cliente, encuentra el punto de conexión correspondiente y enruta la solicitud de forma segura al punto de conexión del modelo alojado en esa cuenta. Los modelos LLM se utilizan para tareas de inferencia, como generar texto o responder preguntas.

No se almacenan datos de clientes en las cuentas de amazon Bedrock, ni se comparten con proveedores de LLM ni se utilizan para ajustar los modelos. Las comunicaciones y transferencias de datos se realizan a través de conexiones de red privadas mediante TLS 1.2+, lo que minimiza el riesgo de exposición de datos o acceso no autorizado.

Al implementar esta arquitectura de múltiples cuentas y conectividad privada, amazon Bedrock proporciona un entorno seguro, garantizando que los datos del cliente permanezcan aislados y seguros dentro de la propia cuenta del cliente, al mismo tiempo que le permite utilizar el poder de los LLM proporcionados por proveedores externos.

Conclusión

La tecnología de inteligencia artificial generativa puede revolucionar la forma en que los miembros de los planes de seguro médico interactúan con sus planes de seguro y acceden a información esencial. Al integrar asistentes de inteligencia artificial conversacional impulsados por amazon Bedrock y usar servicios de datos de AWS diseñados específicamente para este fin, como amazon RDS, las aseguradoras y los planes de seguro de salud pueden brindar una experiencia fluida e intuitiva a sus miembros. Esta solución no solo mejora la satisfacción de los miembros, sino que también puede reducir los costos operativos al optimizar las operaciones de servicio al cliente. Adoptar tecnologías innovadoras como la inteligencia artificial generativa se vuelve crucial para que las organizaciones sigan siendo competitivas y brinden experiencias excepcionales a los miembros.

Para obtener más información sobre cómo la IA generativa puede acelerar las innovaciones en el ámbito de la salud y mejorar las experiencias de los pacientes, consulte Pagadores en AWS y Transformación de la atención al paciente: innovaciones en IA generativa en el ámbito de la atención médica y las ciencias biológicas (parte 1). Para obtener más información sobre el uso de la IA generativa con los servicios de AWS, consulte Crear aplicaciones de IA generativa con amazon Aurora y Bases de conocimiento para amazon Bedrock y la categoría IA generativa en el blog de bases de datos de AWS.

Acerca de los autores

Sachin Jain es arquitecto de soluciones sénior en amazon Web Services (AWS) y se centra en ayudar a los clientes de los sectores sanitario y de las ciencias biológicas en su transición a la nube. Tiene más de 20 años de experiencia en los sectores de la tecnología, la atención sanitaria y la ingeniería.

Sachin Jain es arquitecto de soluciones sénior en amazon Web Services (AWS) y se centra en ayudar a los clientes de los sectores sanitario y de las ciencias biológicas en su transición a la nube. Tiene más de 20 años de experiencia en los sectores de la tecnología, la atención sanitaria y la ingeniería.

Sanjoy Thanneer es gerente técnico sénior de cuentas de AWS y reside en Nueva York. Tiene más de 20 años de experiencia trabajando en los dominios de bases de datos y análisis. Le apasiona ayudar a los clientes empresariales a crear aplicaciones escalables, resistentes y rentables.

Sanjoy Thanneer es gerente técnico sénior de cuentas de AWS y reside en Nueva York. Tiene más de 20 años de experiencia trabajando en los dominios de bases de datos y análisis. Le apasiona ayudar a los clientes empresariales a crear aplicaciones escalables, resistentes y rentables.

Sukhomoy Basak Sukhomoy es arquitecto de soluciones sénior en amazon Web Services y le apasionan los datos, el análisis y las soluciones GenAI. Sukhomoy trabaja con clientes empresariales para ayudarlos a diseñar, crear y escalar aplicaciones para lograr sus resultados comerciales.

Sukhomoy Basak Sukhomoy es arquitecto de soluciones sénior en amazon Web Services y le apasionan los datos, el análisis y las soluciones GenAI. Sukhomoy trabaja con clientes empresariales para ayudarlos a diseñar, crear y escalar aplicaciones para lograr sus resultados comerciales.

NEWSLETTER

NEWSLETTER