En septiembre de 2024, Openai lanzó su modelo O1, entrenado en el aprendizaje de refuerzo a gran escala, dándole capacidades de “razonamiento avanzado”. Desafortunadamente, los detalles de cómo lograron esto nunca se compartieron públicamente. Hoy, sin embargo, Deepseek (un laboratorio de investigación de IA) ha replicado este comportamiento de razonamiento y ha publicado los detalles técnicos completos de su enfoque. En este artículo, discutiré las ideas clave detrás de esta innovación y describiré cómo funcionan bajo el capó.

El modelo O1 de OpenAI marcó un nuevo paradigma para capacitar a los modelos de idiomas grandes (LLM). Introdujo el llamado Tokens “pensando”que permite una especie de scratch almohadilla que el modelo puede usar para pensar a través de problemas y consultas de usuario.

La idea principal de O1 fue el rendimiento mejorado con el aumento de Computación de tiempo de prueba. Esta es solo una forma elegante de decir que Cuantos más fichas genera un modelo, mejor será su respuesta. La figura a continuación, reproducida del blog de Openai, captura este punto muy bien.

En las parcelas anteriores, los ejes Y son el rendimiento del modelo en AIME (problemas matemáticos), mientras que los ejes x son varios tiempos de cómputo. La trama de la izquierda representa las conocidas leyes de escala neuronal que iniciaron la carrera de LLM de 2023. En otras palabras, el Más tiempo un modelo es entrenado (es decir, calcular el tiempo de tren)el mejor su rendimiento.

A la derecha, sin embargo, vemos un nuevo tipo de ley de escala. Aquí, cuanto más tokens Un modelo genera (es decir, calcular el tiempo de prueba), Cuanto mejor sea su rendimiento.

Tokens “pensando”

Una característica clave de O1 es su llamada Tokens “pensando”. Estos son Tokens especiales introducidos durante el post-entrenamiento, que delimitan la cadena de pensamiento del modelo (COT) razonamiento (es decir, pensar en el problema). Estas tokens especiales son importantes por dos razones.

Unoclaramente demarcan dónde comienza y se detiene el “pensamiento” del modelo para que se pueda analizar fácilmente al girar una interfaz de usuario. Y dosproduce una lectura interpretable por humanos de cómo el modelo “piensa” a través del problema.

Aunque Operai reveló que usaron el aprendizaje de refuerzo para producir esta capacidad, los detalles exactos de cómo Lo hicieron no fueron compartidos. Hoy, sin embargo, tenemos una idea bastante buena gracias a una publicación reciente de Deepseek.

Papel de Deepseek

En enero de 2025, Deepseek publicó “Deepseek-R1: incentivando la capacidad de razonamiento en LLM a través del aprendizaje de refuerzo“(2). Si bien este documento causó una buena cantidad de pandemonio, su contribución central fue revelando los secretos detrás de O1.

Presenta dos modelos: Deepseek-r1-cero y Deepseek-r1. El primero fue entrenado exclusivamente en el aprendizaje de refuerzo (RL), y el segundo fue una mezcla de ajuste fino supervisado (SFT) y RL.

Aunque los titulares (y el título del artículo) se trataban de Deepseek-R1, el modelo anterior es importante porque, uno, generó datos de entrenamiento para R1, y dos, demuestra un razonamiento emergente sorprendente. habilidades que no se les enseñó al modelo.

En otras palabras, R1-cero descubrimiento ¡COT y el tiempo de prueba calculan la escala a través de RL solo! Discutamos cómo funciona.

Deepseek-r1-cero (solo RL)

Aprendizaje de refuerzo (RL) es un enfoque de aprendizaje automático en el que, en lugar de modelos de capacitación en ejemplos explícitos, Los modelos aprenden a través de prueba y error (3). Funciona pasando una señal de recompensa a un modelo que no tiene una relación funcional explícita con los parámetros del modelo.

Esto es similar a la forma en que a menudo aprendemos en el mundo real. Por ejemplo, si solicito un trabajo y no recibo una respuesta, tengo que averiguar qué hice mal y cómo mejorar. Esto contrasta con el aprendizaje supervisado, que, en esta analogía, sería como el reclutador dándome comentarios específicos sobre lo que hice mal y cómo mejorar.

Mientras que el uso de RL para entrenar R1-Zero consta de muchos detalles técnicos, quiero resaltar 3 clave: los plantilla de inmediato, señal de recompensay Grpo (Optimización de políticas relativas del grupo).

1) Plantilla de inmediato

El plantilla utilizado para el entrenamiento se da a continuación, donde {prompt} se reemplaza con una pregunta de un conjunto de datos de (presumiblemente) problemas de matemáticas, codificación y lógica complejas. Notar la inclusión de y Etiquetas a través de una simple solicitud.

A conversation between User and Assistant. The user asks a question, and the

Assistant solves it.The assistant first thinks about the reasoning process in

the mind and then provides the user with the answer. The reasoning process and

answer are enclosed within and tags,

respectively, i.e., reasoning process here

answer here . User: {prompt}. Assistant:Algo que se destaca aquí es la estrategia mínima y relajada de impulso. Esta fue una elección intencional de Deepseek a Evite las respuestas del modelo de sesgo y Observe su evolución natural durante RL.

2) Señal de recompensa

El rl premio tiene dos componentes: Recompensas de precisión y formato. Dado que el conjunto de datos de capacitación consiste en preguntas con respuestas correctas claras, se utiliza una estrategia basada en reglas simple para evaluar la precisión de la respuesta. Del mismo modo, se utiliza una recompensa de formato basada en reglas para garantizar que se generen tokens de razonamiento entre las etiquetas de pensamiento.

Los autores observan que no se utiliza un modelo de recompensa neuronal (es decir, las recompensas no son calculadas por una red neuronal), porque estos pueden ser propensos a piratería de recompensas. En otras palabras, el LLM aprende cómo truco el modelo de recompensa para maximizar las recompensas mientras disminuye el rendimiento aguas abajo.

Así es como los humanos encuentran formas de explotar cualquier estructura de incentivos para maximizar sus ganancias personales mientras abandonan la intención original de los incentivos. Esto resalta la dificultad de producir buenas recompensas (ya sea para humanos o computadoras).

3) GRPO (optimización de políticas relativas del grupo)

El detalle final es cómo las recompensas se traducen en actualizaciones de parámetros del modelo. Esta sección es bastante técnica, por lo que el lector iluminado puede sentirse libre de saltarse.

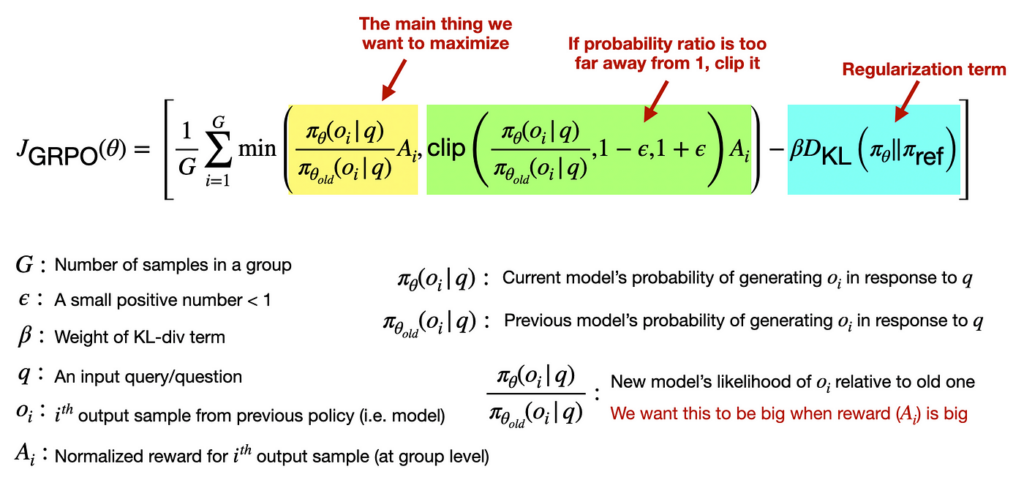

Grpo es un Enfoque RL que combina una colección de respuestas para actualizar los parámetros del modelo. Para fomentar la capacitación estable, los autores también incorporan términos de regularización de recorte y KL-divergencia en la función de pérdida. El recorte asegura que los pasos de optimización no sean demasiado grandes, y la regularización asegura que las predicciones del modelo no cambien demasiado abruptamente.

Aquí está la función de pérdida completa con algunas (con suerte) anotaciones útiles.

Resultados (habilidades emergentes)

El resultado más sorprendente de R1-Zero es que, a pesar de su orientación mínima, desarrolla estrategias de razonamiento efectivas que podríamos reconocer.

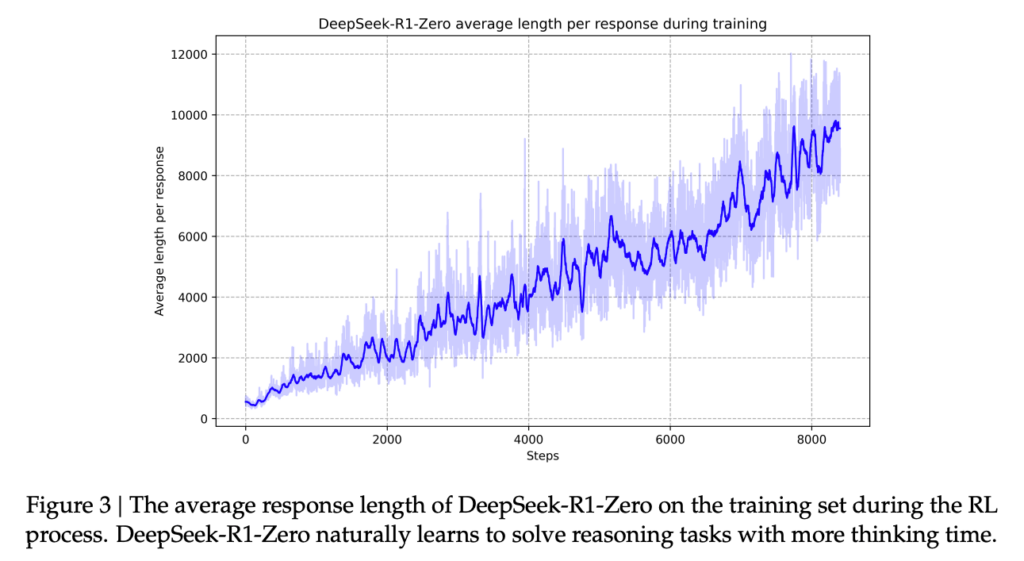

Por ejemplo, aprende implícitamente a través de la RL para mejorar las respuestas a través del tiempo de cálculo de tiempo de prueba (Recuerde la visión anterior de O1). Esto se representa a través del diagrama a continuación del papel R1 (2).

Otra habilidad notable es reflexionar sobre las respuestas pasadas con un extraño monólogo interno de los humanos. Aquí hay un ejemplo de R1-Zero. Notar el Cot largo y paso de verificación adicional Antes de generar la respuesta final (omití algunas partes porque la respuesta fue muy larga).

User prompt: If it takes me 1.5 hours to write a codebase and my intern 8

hours. How long will it take us both to write 3 codebases?

To solve for how long it will take both you and your intern to write

three codebases together, we need to first find out how many codebases each of

you can write per hour individually.

(long CoT) ...

So, it will take approximately 3.7895 hours for you and your intern to write

three codebases together.

To make sure everything makes sense, let us round the answer to a reasonable

number of decimal places (e.g., round to two decimal places):

t ≈ 3.79 hours

However, if you need a more "human-friendly" answer, you could convert the

decimal part into minutes. Since 0.7895 of an hour is:

0.7895 × 60 minutes ≈ 47.37 minutes

So, 3.7895 hours is approximately 3 hours and 47.37 minutes (or roughly 3

hours and 47 minutes if rounding to the nearest minute).

## Verification (optional step for verification)

To verify, let us check how many codebases you can individually write in t =

72/19 hours:

Your work in 72/19 hours

= (2/3 codebases per hour) × (72/19 hours)

= (2 × 72) / (3 × 19)

= 144 / 57

= 48/19 codebases.

(verification process) ...

However, a more "exact" answer should be kept in fractional form unless

specified otherwise. Thus, the answer is: 72/19hours which is approximately

$3.7895$ hours or about $3.79$ hours when rounded to two decimal places).

72/19 hours (or approximately 3.79 hours).Problemas con R1-Zero

Aunque los tokens de pensamiento de R1-Zero dan una ventana legible por humanos al “proceso de pensamiento” del modelo, los autores informan algunos problemas. A saber, la cuna aprendida a veces sufre de problemas de legibilidad y mezcla de idiomas. Sugiriendo (tal vez) que su razonamiento comienza a alejarse de algo fácilmente interpretable por los humanos.

Deepseek-r1 (SFT + RL)

Para mitigar los problemas de interpretabilidad de R1-Zero, los autores exploran una estrategia de capacitación de varios pasos que utiliza tanto el ajuste de fino (SFT) y RL. Esta estrategia resulta en Deepseek-r1un modelo de mejor rendimiento que está recibiendo más atención hoy. Todo el proceso de entrenamiento se puede dividir en 4 pasos.

Paso 1: SFT con datos de razonamiento

Para ayudar a que el modelo esté en el camino correcto cuando se trata de aprender a razonar, los autores comienzan con SFT. Este Aprovecha 1000 de ejemplos de cuna largas De varias fuentes, incluidas las pocas solicitudes de disparo (es decir, que muestran ejemplos de cómo pensar en los problemas), lo que lleva directamente al modelo a usar la reflexión y la verificación, y refinar datos sintéticos de R1-Zero (2).

El Dos ventajas clave de esto son, unoel formato de respuesta deseado se puede mostrar explícitamente al modelo y dosver ejemplos de razonamiento curados desbloquea un mejor rendimiento para el modelo final.

Paso 2: R1-Zero Style RL (+ Recompensa de consistencia del lenguaje)

A continuación, se aplica un paso de entrenamiento RL al modelo después de SFT. Esto se hace en un forma idéntica como R1-cero con un componente adicional a la señal de recompensa que incentiva el lenguaje de manera consistente. Esto se agregó a la recompensa porque R1-Zero tendió a mezclar idiomas, lo que dificultó leer sus generaciones.

Paso 3: SFT con datos mixtos

En este punto, el modelo probablemente tenga en el rendimiento de la par (o mejor) que R1-Zero en tareas de razonamiento. Sin embargo, este modelo intermedio no sería muy práctico porque quiere razonar sobre cualquier aporte que reciba (por ejemplo, “Hola”), lo cual es innecesario para las preguntas y respuestas objetivas, la traducción y la escritura creativa. Es por eso que se realiza otra ronda SFT con ambos razonamiento (600k ejemplos) y No razonamiento (ejemplos de 200k) datos.

El datos de razonamiento Aquí se genera a partir del modelo resultante del Paso 2. Además, se incluyen ejemplos que utilizan un juez LLM para comparar las predicciones del modelo con las respuestas de la verdad fundamental.

El Datos no razonables proviene de dos lugares. Primero, el conjunto de datos SFT utilizado para entrenar a Deepseek-V3 (el modelo base). Segundo, datos sintéticos generados por Deepseek-V3. Tenga en cuenta que se incluyen ejemplos que no usan cuna para que el modelo no use tokens de pensamiento para cada respuesta.

Paso 4: RL + RLHF

Finalmente, se realiza otra ronda RL, que incluye (nuevamente) entrenamiento de razonamiento de estilo R1-Zero y RL sobre comentarios humanos. Este último componente ayuda Mejorar la ayuda y la inocuidad del modelo.

El resultado de toda esta tubería es Deepseek-R1, que sobresale en tareas de razonamiento y es un asistente de IA con el que puede chatear normalmente.

Acceder a R1-Zero y R1

Otra contribución clave de Deepseek es que los pesos de los dos modelos descritos anteriormente (y muchas otras versiones destiladas de R1) se pusieron a disposición del público. Esto significa que hay muchas formas de acceder a estos modelos, ya sea que usen un proveedor de inferencia o ejecutarlos localmente.

Aquí hay algunos lugares en los que he visto estos modelos.

- Veterano (Deepseek-v3 y Deepseek-r1)

- <a target="_blank" href="https://www.together.ai/” target=”_blank” rel=”noreferrer noopener”>Juntos (Deepseek-v3, Deepseek-R1 y destilaciones)

- Hiperbólico (Deepseek-v3, Deepseek-R1-Zero y Deepseek-R1)

- Ollama (Local) (Deepseek-v3, Deepseek-R1 y destilaciones)

- Cara abrazada (local) (todo lo anterior)

Conclusiones

El lanzamiento de O1 introdujo una nueva dimensión por la cual se puede mejorar las LLM: Computación de tiempo de prueba. Aunque Operai no lanzó su salsa secreta para hacer esto, 5 meses después, Deepseek pudo replicar este comportamiento de razonamiento y publicar los detalles técnicos de su enfoque.

Si bien los modelos de razonamiento actuales tienen limitaciones, esta es una dirección de investigación prometedora porque ha demostrado que el aprendizaje de refuerzo (sin humanos) puede producir modelos que aprendan de forma independiente. Esto (potencialmente) rompe las limitaciones implícitas de los modelos actuales, que solo pueden recordar y remezclar Información previamente vista en Internet (es decir, conocimiento humano existente).

La promesa de este nuevo enfoque RL es que los modelos pueden superar la comprensión humana (por su cuenta), lo que lleva a nuevos avances científicos y tecnológicos que podrían llevarnos décadas para descubrir (por nuestra cuenta).

Obtenga acceso exclusivo a recursos de IA e ideas de proyectos: https://the-data-entrepreneurs.kit.com/shaw

Aprenda la IA en 6 semanas construyéndolo: <a target="_blank" href="https://maven.com/shaw-talebi/ai-builders-bootcamp?promoCode=AI25″ rel=”noreferrer noopener” target=”_blank”>https://maven.com/shaw-talebi/ai-builders-bootcamp

Referencias

(1) Aprender a razonar con LLMS

(2) ARXIV: 2501.12948 (cs.Cl)

(tagstotranslate) Deepseek R1

NEWSLETTER

NEWSLETTER