El rápido avance de la inteligencia artificial (IA) ha dado lugar a una nueva era de modelos diseñados para procesar y generar datos en múltiples modalidades. Estos incluyen texto, imágenes, audio y video. Estos modelos multimodales se utilizan cada vez más en diversas aplicaciones, desde la creación de contenidos hasta el análisis avanzado. Este artículo le presentará el concepto de modelos multimodales y comparará 7 de los modelos multimodales más populares (tanto de código abierto como propietarios) disponibles actualmente. Le guiará sobre cuándo y dónde utilizar cada modelo según sus características, casos de uso, accesibilidad y costo.

¿Qué son los modelos multimodales?

Los modelos multimodales son arquitecturas de IA especializadas diseñadas para manejar e integrar datos de diversas modalidades. Pueden realizar tareas como generar texto a partir de imágenes, clasificar imágenes basándose en texto descriptivo y responder preguntas que involucran información tanto visual como textual. Estos modelos suelen entrenarse en grandes conjuntos de datos que contienen diversos tipos de datos, lo que les permite aprender relaciones complejas entre diferentes modalidades.

Los modelos multimodales se han vuelto vitales para tareas que requieren comprensión contextual en diferentes formatos. Por ejemplo, pueden mejorar los motores de búsqueda, mejorar el servicio al cliente a través de chatbots, permitir la generación de contenido avanzado y ayudar con herramientas educativas.

Más información: Explorando la IA generativa multimodal avanzada

Lista de los 7 modelos multimodales más populares

La siguiente tabla compara las modalidades, fortalezas, costos y otros detalles de los 7 modelos multimodales más populares disponibles en la actualidad.

| # | Modelo | Soporte de modalidad | Código abierto/Propietario | Acceso | Costo* | Mejor para | Fecha de lanzamiento |

| 1 | Llama 3.2 90B | Texto, Imagen | Código abierto | ai/playground/chat/meta-llama/Llama-3.2-90B-Vision-Instruct-Turbo” rel=”nofollow”>Juntos IA | $5 gratis en créditos | Seguimiento de instrucciones | Septiembre 2024 |

| 2 | Géminis 1.5 Flash | Texto, Imagen, Vídeo, Audio | Propiedad | IA de Google servicios | Comienza en ai/generative-ai/pricing” rel=”nofollow”>$0.00002 / imagen | Comprensión holística | Septiembre 2024 |

| 3 | Florencia | Texto, Imagen | Código abierto | AbrazosCara | Gratis | Fuerza de visión por computadora | junio 2024 |

| 4 | GPT-4o | Texto, Imagen | Propiedad | AbiertoAI suscripción | Comienza en $2.5 por 1 millón de tokens de entrada | Rendimiento optimizado | mayo 2024 |

| 5 | claudio 3 | Texto, Imagen | Propiedad | ai/new” rel=”nofollow”>claudio ai | Soneto: FreeOpus: $20/mesHaikú: $20/mes | Enfoque ético en la IA | marzo 2024 |

| 6 | LLaVA V1.5 7B | Texto, Imagen, Audio | Código abierto | Nube Groq | Gratis | Interacción en tiempo real | enero 2024 |

| 7 | DESDE Y 3 | Texto, Imagen | Propiedad | AbiertoAI plataforma | Comienza en $0.040 / imagen | Inpainting, generación de alta calidad. | octubre 2023 |

*los precios mencionados están actualizados al 21 de octubre de 2024

Ahora exploremos sus características y casos de uso con más detalle.

1. Llama 3.2 90B

Llama 3.2 90B de Meta ai es actualmente uno de los modelos multimodales más avanzados y populares que se utilizan. Esta última variante de la serie Llama combina capacidades de seguimiento de instrucciones con interpretación avanzada de imágenes, atendiendo a una amplia gama de necesidades del usuario. El modelo está diseñado para facilitar tareas que requieren tanto comprensión como generación de respuestas basadas en entradas multimodales.

Características:

- Instrucción siguiente: Diseñado para manejar instrucciones de usuario complejas que involucran tanto texto como imágenes.

- Alta eficiencia: Capaz de procesar grandes conjuntos de datos rápidamente, mejorando su utilidad en entornos dinámicos.

- Interacción multimodal robusta: Integra texto y datos visuales para proporcionar respuestas integrales.

Casos de uso:

- Plataformas de aprendizaje interactivo: Ayuda a proporcionar instrucciones y explicaciones para contenido visual complejo, lo que hace que el aprendizaje sea más atractivo.

- Aplicaciones de soporte técnico: Útil para guiar a los usuarios a través de procesos de solución de problemas con una combinación de imágenes e instrucciones paso a paso.

2. Géminis 1.5 Flash

Gemini 1.5 Flash es el último modelo multimodal liviano de Google, experto en procesar texto, imágenes, video y audio, con gran velocidad y eficiencia. Su capacidad para proporcionar información integral sobre diferentes formatos de datos lo hace adecuado para aplicaciones que requieren una comprensión más profunda del contexto.

Características:

- Procesamiento multimedia: Maneja múltiples tipos de datos simultáneamente, lo que permite interacciones enriquecidas.

- Inteligencia conversacional: Particularmente eficaz en diálogos de varios turnos, donde el contexto de interacciones anteriores es vital.

- Generación de respuesta dinámica: Genera respuestas que reflejan una comprensión de diversos aportes de los medios.

Casos de uso:

- Asistentes virtuales: Mejora la funcionalidad de los asistentes inteligentes al permitirles responder a consultas que involucran tanto texto como imágenes.

- Herramientas de creación de contenido: Útil para generar contenido multimedia para redes sociales o sitios web, combinando texto e imágenes a la perfección.

3. Florencia 2

Florence 2 es un modelo liviano de Microsoft, diseñado principalmente para tareas de visión por computadora y al mismo tiempo integra entradas de texto. Sus capacidades le permiten realizar análisis complejos de contenido visual. Esto lo convierte en un modelo invaluable para aplicaciones de lenguaje visual como OCR, subtítulos, detección de objetos, segmentación de instancias, etc.

Características:

- Fuerte reconocimiento visual: Destaca en la identificación y categorización de contenido visual, proporcionando información detallada.

- Procesamiento de consultas complejas: Maneja consultas de usuarios que combinan texto e imágenes de manera efectiva.

Casos de uso:

- Etiquetado de contenido automatizado: Agiliza la gestión del contenido visual etiquetando automáticamente las imágenes según sus atributos.

- Sistemas visuales de respuesta a preguntas: Permite a los usuarios realizar preguntas sobre imágenes, generando respuestas informativas y relevantes.

4. GPT-4o

GPT-4o es una versión optimizada de GPT-4, diseñada para brindar eficiencia y rendimiento en el procesamiento tanto de texto como de imágenes. Su arquitectura permite respuestas rápidas y resultados de alta calidad, lo que la convierte en la opción preferida para diversas aplicaciones.

Características:

- Rendimiento optimizado: Velocidades de procesamiento más rápidas sin sacrificar la calidad de salida, adecuadas para aplicaciones en tiempo real.

- Capacidades multimodales: Maneja eficazmente una amplia gama de consultas que involucran datos tanto textuales como visuales.

Casos de uso:

- Plataformas de participación del cliente: Mejora la interacción al proporcionar respuestas inmediatas y relevantes basadas en las aportaciones del usuario.

- Asistentes de escritura creativa: Apoya a los escritores generando ideas y narrativas que se alinean con los elementos visuales proporcionados.

5. Claudio 3.5

Claudio 3.5 es un modelo multimodal desarrollado por Anthropic, que se centra en la IA ética y las interacciones seguras. Este modelo combina el procesamiento de texto e imágenes priorizando la seguridad y satisfacción del usuario. Está disponible en tres tamaños: Haiku, Sonnet y Opus.

Características:

- Protocolos de seguridad: Diseñado para minimizar los resultados dañinos, asegurando que las interacciones sigan siendo constructivas.

- Calidad de interacción similar a la humana: Hace hincapié en la creación de respuestas naturales y atractivas, haciéndola adecuada para una audiencia amplia.

- Comprensión multimodal: Integra eficazmente texto e imágenes para proporcionar respuestas integrales.

Casos de uso:

- Plataformas Educativas: Proporciona comentarios sobre el trabajo visual, lo que ayuda a los alumnos a mejorar y, al mismo tiempo, garantiza un entorno seguro.

- Moderación de contenido: Ayuda a filtrar contenido inapropiado al comprender entradas tanto textuales como visuales.

6. LLaVA V1.5 7B

LLaVA (Asistente de visión y lenguaje grande) es un modelo perfeccionado. Utiliza el ajuste de instrucciones visuales para respaldar el seguimiento de instrucciones naturales basadas en imágenes y las capacidades de razonamiento visual. Su pequeño tamaño lo hace adecuado para aplicaciones interactivas, como chatbots o asistentes virtuales, que requieren interacción en tiempo real con los usuarios. Sus puntos fuertes residen en el procesamiento de texto, audio e imágenes simultáneamente.

Características:

- Interacción en tiempo real: Proporciona respuestas inmediatas a las consultas de los usuarios, lo que hace que las conversaciones se sientan más naturales.

- Conciencia contextual: Mejor comprensión de las intenciones de los usuarios que combinan varios tipos de datos.

- Respuesta visual a preguntas: Identifica texto en imágenes mediante el reconocimiento óptico de caracteres (OCR) y responde preguntas basadas en el contenido de la imagen.

Casos de uso:

- Subtítulos de imagen: Ayuda a generar descripciones de texto de imágenes, lo que facilita que los usuarios con discapacidad visual comprendan el contenido de las imágenes.

- Sistemas de diálogo multimodal: Ayuda a los chatbots de servicio al cliente a entablar conversaciones con los clientes, respondiendo consultas textuales y visuales sobre los productos.

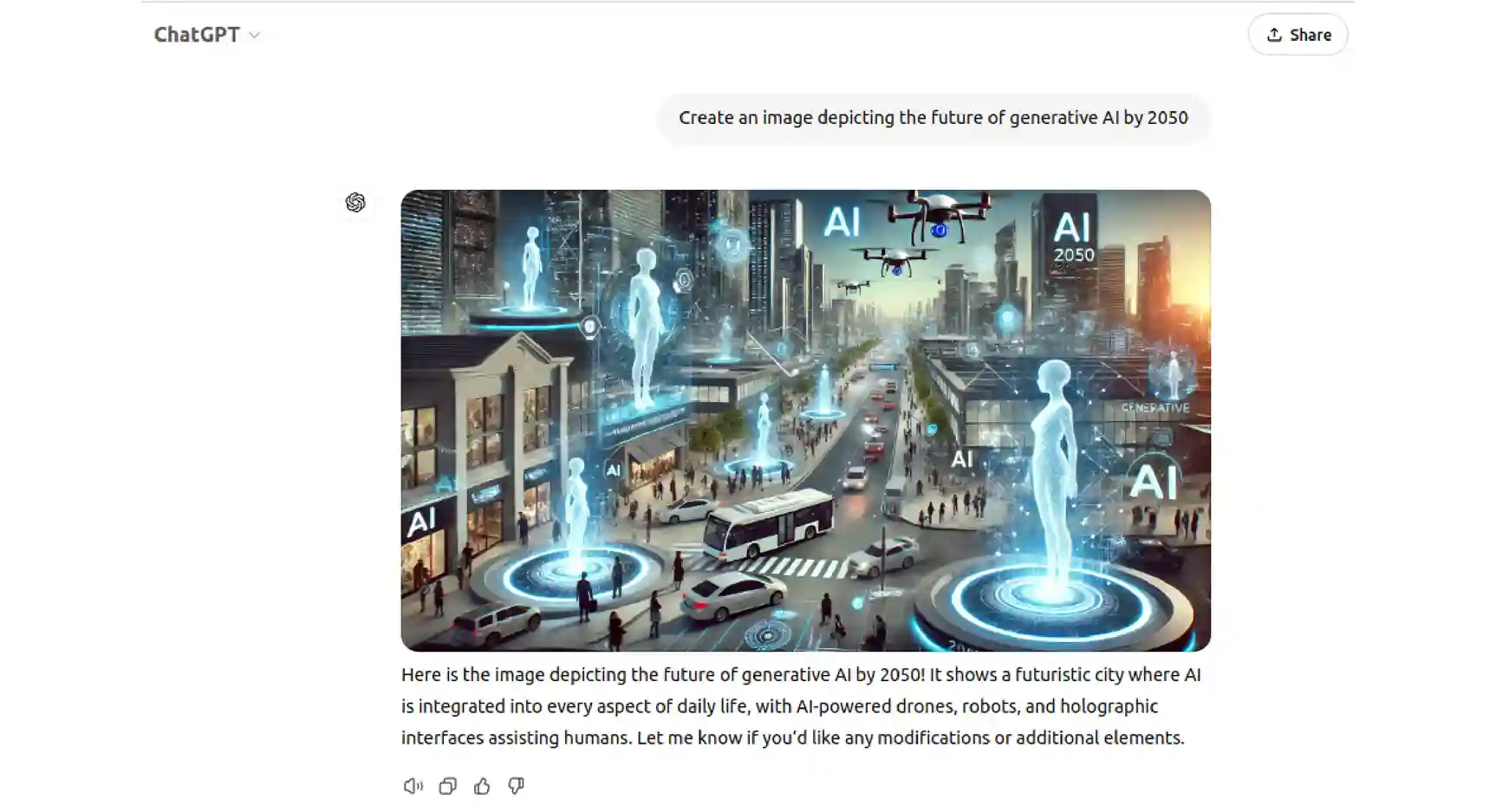

7. DESDE Y 3

DALL·E 3 de Open ai es un potente modelo de generación de imágenes que traduce descripciones textuales en imágenes vívidas y detalladas. Este modelo es conocido por su creatividad y capacidad para comprender indicaciones matizadas, lo que permite a los usuarios generar imágenes que se asemejan mucho a su imaginación.

Características:

- Generación de texto a imagen: Convierte indicaciones detalladas en imágenes únicas, lo que permite amplias posibilidades creativas.

- Funcionalidad de pintura: Los usuarios pueden modificar imágenes existentes describiendo cambios en el texto, ofreciendo flexibilidad en la edición de imágenes.

- Comprensión avanzada del lenguaje: Comprende mejor el contexto y las sutilezas del lenguaje, lo que da como resultado representaciones visuales más precisas.

Casos de uso:

- Campañas de marketing: Las empresas pueden generar rápidamente imágenes personalizadas para anuncios sin necesidad de conocimientos de diseño gráfico.

- Creación de arte conceptual: Los artistas pueden utilizar el modelo para generar ideas y visualizar conceptos, acelerando el proceso creativo.

Conclusión

Los modelos multimodales están superando los límites de la IA al integrar varios tipos de datos para realizar tareas cada vez más complejas. Desde combinar texto e imágenes hasta analizar videos en tiempo real con audio, estos modelos abren nuevas posibilidades en industrias como la atención médica, la creación de contenido y la realidad virtual.

En este artículo, exploramos las características y los casos de uso de 7 modelos populares de IA multimodal. Sin embargo, seleccionar el modelo correcto depende de la tarea específica en cuestión. Ya sea que esté generando imágenes, analizando diversas entradas de datos u optimizando videos en tiempo real, existe un modelo multimodal especializado para ello. A medida que la IA siga evolucionando, los modelos multimodales incluirán más tipos de datos para casos de uso más complejos y diversos.

Más información: ¿Qué futuro le espera a la IA multimodal?

Preguntas frecuentes

R. Los modelos multimodales son sistemas de inteligencia artificial que pueden procesar y generar datos en múltiples modalidades, como texto, imágenes, audio, video y más, lo que permite una amplia gama de aplicaciones.

R. Los modelos multimodales son útiles en aplicaciones que requieren comprender o generar datos en diferentes formatos, como combinar texto e imágenes para mejorar el contexto.

R. Los modelos tradicionales normalmente se centran en un solo tipo de datos (como texto o imágenes), mientras que los modelos multimodales pueden integrar y procesar múltiples tipos de datos simultáneamente.

R. El costo de un modelo multimodal puede variar ampliamente según el modelo, el uso y el método de acceso. Sin embargo, algunos modelos multimodales están disponibles de forma gratuita u ofrecen opciones de código abierto.

R. La mayoría de los modelos multimodales analizados en este artículo están disponibles a través de API o plataformas como HuggingFace.

R. Dependiendo del modelo, algunos pueden ofrecer opciones de ajuste, mientras que otros están principalmente entrenados previamente y no están pensados para la personalización a nivel de usuario.

R. Se crean diferentes modelos multimodales para manejar diferentes tipos de datos. Esto puede incluir texto, imagen, video y audio.

NEWSLETTER

NEWSLETTER